Facebook utilise l’intelligence artificielle pour prévoir vos actions futures au profit des annonceurs, indique un document confidentiel

Par Sam Biddle

The Intercept, 13-04-2018

Depuis que le scandale Cambridge Analytica a éclaté en mars, Facebook a essayé de prendre une position morale sur votre vie privée, se démarquant des pratiques sans scrupules de la société de conseil politique britannique. « La protection des données personnelles est au cœur de tout ce que nous faisons », a écrit Paul Grewal, l’avocat général adjoint de Facebook, quelques semaines avant que Mark Zuckerberg, fondateur et PDG, se rende au Capitole pour donner des assurances similaires, en disant aux législateurs : « A tous les niveaux, nous avons la responsabilité, non seulement de développer des outils, mais aussi de veiller à ce que ces outils soient utilisés à bon escient ». Mais, en réalité, un document confidentiel de Facebook examiné par le journal The Intercept, montre que les deux compagnies sont beaucoup plus semblables que ce que le réseau social voudrait vous faire croire.

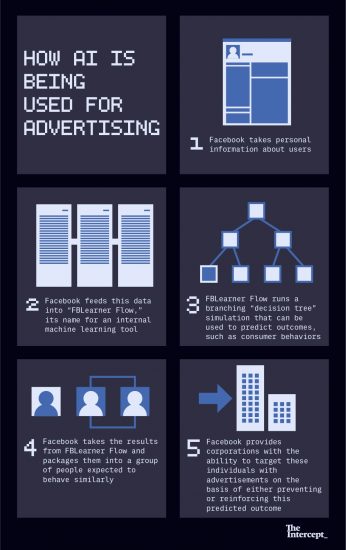

Ce document récent, qualifié de « confidentiel », expose les grandes lignes d’un nouveau service de publicité qui élargit la façon dont le réseau social vend aux entreprises l’accès à ses utilisateurs et à leur vie : Au lieu de simplement offrir aux annonceurs la possibilité de cibler les gens en fonction de la démographie et des préférences des consommateurs, Facebook offre plutôt la possibilité de les cibler en fonction de leur comportement à venir, de ce qu’ils achèteront et de ce qu’ils penseront. Ces capacités sont le fruit d’un système de prédiction basé sur l’intelligence artificielle, dévoilé pour la première fois par Facebook en 2016 et surnommé « FBLearner Flow ».

Une page du document fait état de la capacité de Facebook à « prédire les comportements futurs », permettant aux entreprises de cibler les gens sur la base de décisions qu’ils n’ont même pas encore prises. Potentiellement, cela pourrait donner à des tiers l’occasion de modifier la trajectoire prévue d’un consommateur. Ici, Facebook explique comment il peut passer au peigne fin toute sa base d’utilisateurs, riche de plus de 2 milliards d’individus, pour en extraire des millions de personnes « à risque », qui pourraient quitter une marque au profit d’un concurrent. Ces personnes pourraient alors être ciblées par des messages publicitaires agressifs qui pourraient anticiper et faire changer complètement leur décision – ce que Facebook appelle « une efficacité marketing renforcée ». Ce n’est pas Facebook qui vous montre des publicités Chevrolet parce que vous avez consulté le site Ford toute la semaine – un truc vieux comme le monde dans la sphère du marketing en ligne – mais plutôt Facebook qui utilise les faits de votre vie pour prédire que, dans un futur proche, vous allez en avoir marre de votre voiture. Facebook appelle ce service « Prédiction de fidélité ».

Facebook explique qu’il peut passer au peigne fin ses 2 milliards d’utilisateurs pour en qualifier des millions de « à risque », susceptibles de passer à une marque concurrente.

Dans l’esprit, la publicité de Facebook par l’intelligence artificielle est proche du profilage « psychographique » controversé des électeurs par Cambridge Analytica, qui utilise les données démographiques banales des consommateurs (ce qui vous intéresse, où vous vivez) pour prédire l’action politique. Mais contrairement à Cambridge Analytica et à ses pairs, qui doivent se contenter des données qu’ils peuvent extraire des interfaces publiques de Facebook, Facebook est assis sur le filon principal, avec un accès sans entrave aux bases de données colossales sur le comportement et les préférences. Un rapport ProPublica de 2016 a trouvé quelques 29 000 critères caractérisant chacun des utilisateurs de Facebook.

Zuckerberg a œuvré à démarquer son entreprise de Cambridge Analytica, dont les actions pour le compte de Donald Trump ont été alimentées par les données de Facebook, disant aux journalistes, lors d’une récente conférence téléphonique, que le réseau social est un gardien attentif de l’information :

La vaste majorité des données que Facebook connaît de vous, c’est parce que vous avez choisi de les partager. D’accord ? Vous n’êtes pas pistés. Il y a d’autres compagnies de l’Internet, des courtiers en données ou des gens qui pourraient essayer de pister pour vendre des données, mais nous n’achetons pas ni ne vendons… Pour une raison que j’ignore, nous n’avons pas réussi à éradiquer cette idée très répandue , depuis des années, que nous voulions vendre des données aux annonceurs. Ce n’est pas le cas. Ce n’est pas une chose que nous faisons. En fait, cela va à l’encontre de nos propres intérêts. Même si nous voulions le faire, cela n’aurait pas de sens.

Le document de Facebook fait un geste similaire en faveur de la protection des utilisateurs, soulignant que toutes les données sont « agrégées et rendues anonymes [pour protéger] la vie privée des utilisateurs », ce qui signifie que Facebook loue l’accès à ses données plutôt que de les vendre. Mais cette ligne de défense se contente de jouer sur les mots : Peu importe qui exploite les données brutes de Facebook, le résultat final, que la compagnie s’empresse de monétiser, est une connaissance publicitaire qui touche à votre intimité – désormais emballée et enrichie par le projet d’apprentissage automatique de la compagnie. Et bien que Zuckerberg et compagnie disent techniquement l’exacte vérité en avançant que Facebook ne vend pas vos données, ce qu’ils vendent vraiment est beaucoup plus précieux, le genre de connaissances du 21e siècle qui ne sont accessibles que pour une entreprise aux ressources à peu près illimitées. La réalité est que Zuckerberg a beaucoup plus en commun avec des compagnies comme Equifax et Experian que toute autre entreprise axée sur le consommateur. Facebook est essentiellement un grossiste en données, point final.

Le document ne détaille pas lesquelles des informations des profils utilisateurs de Facebook sont utilisées pour alimenter le système de prédiction, mais il mentionne la géolocalisation, les informations sur les équipements, les détails du réseau Wi-Fi, l’utilisation de vidéos, les affinités et les détails des amitiés, y compris comment un utilisateur est comparable à ses amis. Toutes ces données peuvent ensuite alimenter FBLearner Flow, qui s’en servira essentiellement modéliser une facette de la vie d’un utilisateur, dont les résultats seront vendus à une entreprise cliente. L’entreprise décrit cette pratique comme étant « l’expertise de Facebook en matière d’apprentissage automatique » utilisée pour les « défis fondamentaux de l’entreprise ».

Les experts consultés par The Intercept avancent que les systèmes décrits dans le document soulèvent divers problèmes éthiques, y compris la façon dont la technologie pourrait être utilisée pour manipuler les utilisateurs, influencer les élections ou renforcer le pouvoir des entreprises. Facebook a l’obligation morale de révéler comment il utilise l’intelligence artificielle pour monétiser vos données, a déclaré Tim Hwang, directeur de la Harvard-MIT Ethics and Governance of AI Initiative [Initiative Harvard – MIT sur l’éthique et la gouvernance en matière d’intelligence artificielle], même si Facebook a, en réalité, tout intérêt à garder secrète sa technologie. « Le fait de dire aux gens que les prédictions peuvent se produire peut en soi influencer les résultats », a dit M. Hwang.

Les arrivées d’air extérieures sont vues lors d’une visite du nouveau centre de données Facebook le 19 avril 2012 à Forest City, Caroline du Nord. Photo : Rainier Ehrhardt/Getty Images

Facebook a été harcelé de controverses sur les données et de scandales relatifs à la protection de la vie privée d’une forme ou d’une autre – à un degré presque comique – tout au long de ses 14 ans d’histoire. Malgré des excuses répétées d’année en année de la part de la compagnie, rien ne change vraiment. C’est peut-être la raison pour laquelle l’entreprise s’est jusqu’à présent concentrée sur ses utilisations bienveillantes et sympathiques de l’intelligence artificielle, ou IA.

FBLearner Flow a été présenté comme un ensemble de logiciels à usage interne qui aideraient Facebook à s’adapter à vos préférences chaque fois que vous vous connectez. « Beaucoup des expériences et des échanges que les gens ont aujourd’hui sur Facebook sont rendues possibles grâce à l’IA », a écrit Jeffrey Dunn, ingénieur de Facebook, dans un billet d’introduction au sujet de FBLearner Flow.

Interrogé par Stacey Higginbotham de Fortune sur les objectifs à cinq ans de Facebook en matière d’apprentissage automatique, Mike Schroepfer, directeur de la technologie, a déclaré en 2016 qu’il visait à faire que l’IA « crée chacun des moments que vous passez sur le contenu et les personnes avec qui vous voulez le passer ». L’utilisation de cette technologie pour la publicité n’a pas été mentionnée. Un article de TechCrunch 2017 déclarait : « L’intelligence artificielle est l’avenir de la monétisation pour Facebook », mais ne citait les dirigeants de Facebook que de la manière la plus édulcorée : « Nous voulons comprendre si vous êtes intéressé par quelque chose en général, ou bien tout le temps. Certaines choses que les gens font de façon périodique, hebdomadaire ou à un moment précis, et il est utile de savoir comment cela va et vient », a déclaré Mark Rabkin, vice-président de l’ingénierie publicitaire de Facebook. La compagnie a également été vague au sujet de la combinaison d’apprentissage automatique et de la publicité dans un article de 2017 de la revue Wired consacré aux travaux de l’entreprise en matière d’intelligence artificielle, qui faisait allusion aux essais « pour afficher des annonces plus pertinentes » en utilisant l’apprentissage automatique et pour anticiper les annonces auxquelles les consommateurs seraient les plus susceptibles de cliquer, une utilisation bien ancrée de l’intelligence artificielle. Plus récemment, lors de son audition devant le Congrès, M. Zuckerberg a présenté l’intelligence artificielle comme un outil de lutte contre le discours de haine et le terrorisme.

Mais d’après le document, le service enrichi d’intelligence artificielle que Facebook semble offrir va bien au-delà de « comprendre si vous êtes intéressé par quelque chose en général, ou bien tout le temps ». Pour Frank Pasquale, professeur de droit à l’Université du Maryland et chercheur au Yale’s Information Society Project qui se consacre à l’éthique algorithmique, ce type de marketing basé sur de la modélisation comportementale ressemble à une machine à apprendre le « racket de protection ». Comme il l’a dit à The Intercept :

Vous pouvez considérer que Facebook assure une surveillance protectrice [sur] la façon dont les concurrents vont essayer d’attirer des clients… Nous pouvons superviser pour vous et voir quand votre rival essaie de vous piquer quelqu’un, [puis] nous allons intervenir et nous assurer qu’ils reste dans votre camp.

L’intelligence artificielle est plus ou moins devenue un mot branché comme n’importe quel autre, mais au sens large, elle inclut des technologies comme « l’apprentissage automatique », grâce auquel les ordinateurs apprennent, essentiellement par eux-mêmes, à être de plus en plus efficaces dans des tâches aussi diverses que la reconnaissance faciale et la détection de la fraude financière. Vraisemblablement, FBLearner Flow apprend à être chaque jour plus précis.

Facebook est loin d’être la seule compagnie qui s’efforce de transformer les innovations de la recherche sur l’IA en une source de revenus, mais ils sont dans une situation unique. Même Google, avec son emprise sur les recherches sur le web et les e-mails et, également, des budgets illimités, ne dispose pas ce qu’a Zuckerberg : Une liste de 2 milliards de personnes avec ce qu’elles aiment, ce qu’elles pensent et qui elles connaissent. Facebook peut embaucher les meilleurs et les plus brillants des docteurs et dépenser une somme d’argent inépuisable dans la capacité de traitement.

La division IA de Facebook s’est tournée vers différentes techniques d’apprentissage automatique, parmi lesquelles les « Gradient boosted decision trees », ou GBDT [arbres de décision boostés par gradient,NdT] qui, selon le document, sont utilisés à des fins publicitaires. Un article de 2017 de la revue Proceedings of Machine Learning Research décrit le GBDT comme « une technique d’apprentissage automatique puissante, qui possède un large éventail d’applications commerciales et académiques et produit des résultats de pointe pour de nombreux problèmes complexes d’exploration de données ». Cette technique d’apprentissage automatique est de plus en plus populaire dans l’industrie de l’exploration de données.

Le vif intérêt de Facebook à aider des clients à produire de la valeur à partir des données des utilisateurs contribue peut-être à expliquer pourquoi la compagnie n’a pas condamné ce que Cambridge Analytica a fait avec les données extraites du réseau social – au lieu de cela, l’indignation de Facebook s’est concentrée sur la tromperie de Cambridge Analytica. Grâce à l’équipe de communication de Facebook, le débat a porté sur « l’accès inapproprié » de Cambridge Analytica aux données de Facebook, plutôt que sur les raisons pour lesquelles Cambridge Analytica voulait les données de Facebook au départ. Mais une fois que vous enlevez la question de l’accès et de l’origine, Cambridge Analytica commence à ressembler à la petite sœur de Facebook, en moins ambitieuse.

La capacité à atteindre la population cible a déjà causé des problèmes à Facebook, à de nombreuses reprises, en partie parce que les systèmes publicitaires de la compagnie sont conçus avec un incroyable niveau d’automatisation. Des journalistes de ProPublica ont récemment réussi à envoyer des publicités ciblées à des groupes douteux comme ceux qui se proclament « Jew haters » [ceux qui haïssent les Juifs, NdT]. Qu’il s’agisse d’une campagne politique visant à effrayer un certain type d’électeurs indécis, ou de Russes qui tentent simplement de semer la pagaille, la technique publicitaire de Facebook a été utilisée à plusieurs reprises à des fins troublantes, et il reste à savoir si une entité devrait avoir la possibilité de vendre l’accès à plus de 2 milliards d’usagers dans le monde entier. Pendant ce temps, Facebook semble accélérer, plutôt que de modérer, le caractère opaque de son modèle économique. Venant de la part d’une compagnie qui a été vivement critiquée pour son usage d’algorithmes anonymes pour mener ses affaires, le choix de l’intelligence artificielle auto-apprenante pour explorer des données n’a rien de rassurant.

Le fait que Facebook propose de vendre sa capacité à prédire vos actions – et votre fidélité – revêt une importance particulière au lendemain de l’élection de 2016, dans laquelle l’équipe numérique de Trump a utilisé le ciblage Facebook pour remporter un succès historique. Facebook travaille régulièrement avec des équipes de campagnes dans le monde entier et se vante de sa capacité d’influencer le taux de participation – une « success story » de Facebook, sur son travail avec le Scottish National Party, décrit la collaboration comme ayant « déclenché un raz-de-marée ». Depuis que Zuckerberg a honteusement nié la capacité de Facebook à influencer les élections, capacité dont Facebook avait auparavant fait la promotion, la compagnie peine se justifier. Tant que Facebook ne reconnaît pas sa capacité d’influence basée sur sa connaissance des gens, est-il normal que l’entreprise poursuive son développement en matière d’influence à partir des prédictions sur les individus?

Jonathan Albright, directeur de recherche au Tow Center for Digital Journalism de l’Université Columbia, a déclaré à The Intercept que, comme tout algorithme, en particulier ceux de Facebook, le ciblage par l’IA « peut toujours être utilisé comme une arme ». Albright, qui est devenu un détracteur de la capacité de Facebook à canaliser l’influence politique, s’inquiète de la manière dont ces techniques pourraient être utilisées dans le cadre d’élections, en prédisant quelles « personnes… pourraient être poussées à ne pas voter », par exemple.

« Une fois qu’ils ont fait cette prédiction, ils ont un intérêt financier à ce qu’elle se réalise. »

Une section du document met en lumière une réussite de Facebook qui a aidé un client à monétiser un groupe ethnique spécifique, bien que la méthode employée – FBLearner Flow ou plus conventionnelle – ne soit pas claire. Facebook a supprimé la possibilité de cibler les groupes ethniques en fin d’année dernière après la publication d’un rapport de ProPublica.

Pasquale, le professeur de droit, a déclaré à The Intercept que le travail de prédiction comportementale de Facebook avait de quoi donner des frissons. Il s’inquiète de la façon dont l’entreprise pourrait transformer les prédictions algorithmiques en « prophéties auto-réalisatrices », car « une fois qu’ils ont fait cette prédiction, ils ont un intérêt financier à ce qu’elle se réalise ». Quand Facebook prédit à un annonceur ce que vous allez faire le mois suivant, il incombe à l’entreprise, soit de faire en sorte que l’événement se produise, soit de montrer qu’elle a réussi à l’empêcher efficacement (ceci dit, comment Facebook pourrait-il assurer à son client que c’est son action qui a changé l’avenir ?).

Les incitations créées par l’IA sont déjà problématiques lorsque la technologie est utilisée pour pousser à l’achat, mais plus encore si elle est utilisée pour un scrutin. Rumman Chowdhury, qui dirige Responsible AI initiative d’Accenture, a souligné le fait que, comme les suggestions de Netflix ou d’Amazon, les prédictions algorithmiques plus ambitieuses pourraient non seulement deviner le comportement d’un utilisateur de Facebook, mais aussi le renforcer : « Les moteurs de recommandation sont incités à vous donner des liens sur lesquels vous cliquerez, pas nécessairement des informations utiles ».

Facebook n’a ni répondu aux questions répétées sur les types de données d’utilisateurs utilisés pour les prédictions comportementales, ni indiqué si cette technologie pourrait être utilisée dans des contextes plus sensibles comme les campagnes politiques ou les soins de santé. Au lieu de cela, l’équipe de relations publiques de Facebook a déclaré que l’entreprise utilise « FBLearner Flow pour gérer différents types de processus » et que « l’apprentissage automatique est un type de processus qu’il peut gérer ». Facebook a nié que FBLearner Flow soit utilisé pour des applications de marketing (une « mauvaise interprétation ») et a déclaré avoir « indiqué publiquement, en toute transparence, l’utilisation de l’apprentissage automatique dans le domaine de la publicité », faisant référence à l’article de 2017 de Wired.

Autre problème : la réticence de Facebook expliquer comment il monétise l’IA. Albright voit dans cette réticence un symptôme du « conflit inhérent » entre Facebook et la « responsabilité », car « ils ne peuvent tout simplement pas divulguer au public la plupart des détails sur ces sujets car il s’agit du cœur de leur modèle économique ».

Facebook a dit qu’il utilise « FBLearner Flow pour gérer différents types de processus ».

Mais Facebook n’a jamais souhaité divulguer quoi que ce soit hormis les exigences de la Securities and Exchange Commission et sa communication de crise. L’entreprise a prouvé à maintes reprises qu’elle pouvait falsifier les faits, puis, rattrapée par la réalité, s’en sortir avec des déclarations boiteuses à la presse et des messages insipides de Zuckerberg.

Et pourtant, le nombre de personnes dans le monde qui utilisent Facebook (et la trésorerie de l’entreprise) continue d’augmenter. Facebook a joui d’une sorte d’immunité d’image, du moins jusqu’au scandale de Cambridge Analytica. Une chaîne de fast-food qui serait, par exemple, accusée de négligence envers ses clients, ne s’en sortirait sans doute pas indemne. Il est possible que les gens ne se soucient pas assez de leur vie privée pour que leur colère conduise Facebook à changer de façon significative.

Peut-être que suffisamment d’utilisateurs de Facebook se résignent à l’idée d’avoir signé un pacte avec le démon du Big Data, et s’attendent à ce que leur vie personnelle serve à alimenter les algorithmes d’apprentissage automatique publicitaire. Hwang a noté que « nous ne pouvons pas oublier l’histoire de tout cela. La publicité, en tant qu’industrie, depuis des décennies, tourné autour de la prédiction du comportement… des individus et des groupes… C’est en quelque sorte le but de la publicité ». Mais nous ne pouvons pas non plus nous attendre à ce que les utilisateurs de Facebook, ou de toute autre technologie, soient en capacité de décider de ce qui vaut la peine d’être dénoncé et ce qui vaut la peine d’être craint , alors qu’ils sont délibérément maintenus dans un état d’ignorance quasi-totale. Chipotle [une chaîne de restauration rapide, NdT] est obligé réglementairement de vous informer précisément sur ce qui vous est servi, et sur les quantités. Facebook n’a pas l’obligation d’expliquer ce qu’il fait exactement de vos données au-delà des révisions successives de sa politique de confidentialité, qui se contente de lister ce que Facebook se réserve le droit de faire. Nous savons que Facebook s’est engagé dans le même genre d’interférence politique, amorale, que Cambridge Analytica parce qu’ils avaient l’habitude de s’en vanter sur leur site Web. Maintenant, les vantardises ont disparu, sans explication, et nous sommes de nouveau dans l’obscurité.

Ainsi, bien que les détails de ce qui est fait de vos données demeurent en grande partie une question de secret commercial pour Facebook, nous pouvons considérer ce qui suit : Mark Zuckerberg affirme que son entreprise a « la responsabilité de protéger vos données, et si nous ne le pouvons pas, nous ne méritons pas d’être à votre service ». D’un autre côté, Zuckerberg dirige une entreprise qui utilise vos données pour alimenter des modèles de prédiction par l’IA, qui seront utilisés pour vous cibler et vous soutirer de l’argent sur la base de ce que vous allez faire à l’avenir. Il semble difficile de concilier ces deux faits – peut-être parce que c’est impossible.

Traduit par les lecteurs du site www.les-crises.fr.

/image%2F0780719%2F20170521%2Fob_98bcb0_medias11.jpg)

/file%2F0780719%2F20240417%2Fob_8df2fd_kit-graph-1.webp)

/image%2F0780719%2F20240203%2Fob_959d81_facbook.png)

/image%2F0780719%2F20240120%2Fob_d03f4b_censure-facebook.jfif)

/file%2F0780719%2F20231018%2Fob_e39c40_gaza-bomb-hospital.webp)

/image%2F0780719%2F20240424%2Fob_4d04d9_sunak-kagame2.jpg)

/image%2F0780719%2F20240424%2Fob_b0745d_france-2a.jpg)

/image%2F0780719%2F20240424%2Fob_61b018_panot.jpg)

/file%2F0780719%2F20240424%2Fob_4467b3_schumer1.webp)

/file%2F0780719%2F20240424%2Fob_2a531d_borrell.webp)

/file%2F0780719%2F20240424%2Fob_37e50f_biden23.webp)

Haut de page

Haut de page