Ce sondage présente à l’évidence de lourdes lacunes méthodologiques, imperfections et inductions qui font que sa conception ne pouvait que produire un tel résultat.

Les nombreux biais que nous allons analyser ici expliquent pourquoi les critiques de ce sondage ont été presque unanimes :

I. Le sondage

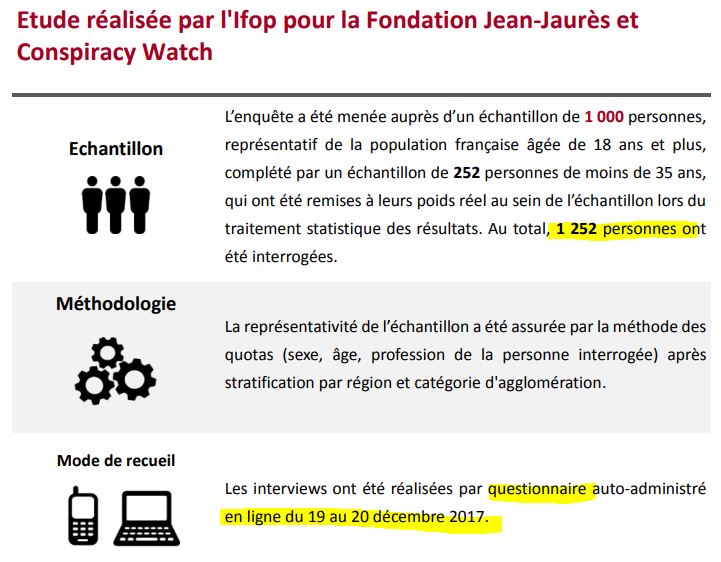

Cette “Enquête sur le complotisme” porte sur 1 252 personnes (1 000 représentatives de la population + 252 personnes en plus, de moins de 35 ans, le tout ayant été redressé pour rester représentatif) et a été réalisée les 19 et 20 décembre par un questionnaire sur Internet :

Il est consultable ici (source).

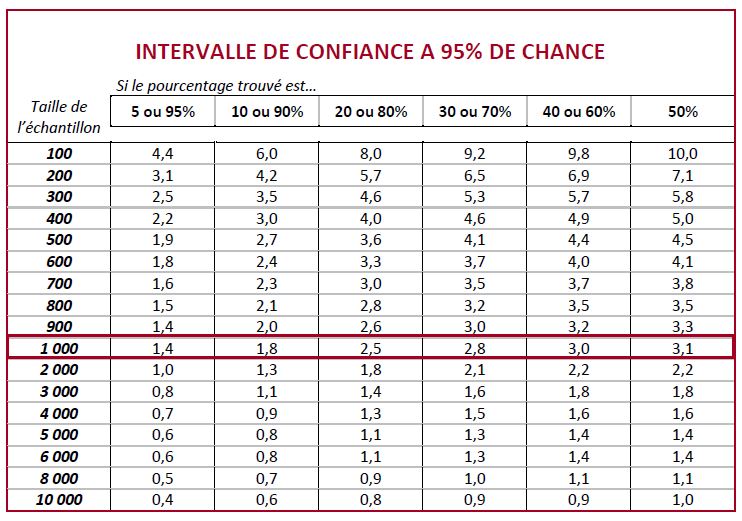

C’est un sondage qui aura donc pour les réponses de l’ensemble des sondés, une marge d’erreur d’au moins 2 à 3 points, et, pour les sous-catégories d’au moins 5 à 8 points.

Confronté à de multiples critiques, Jérôme Fourquet, le directeur à l’IFOP ayant supervisé l’étude, a précisé ceci (Source) :

“L’enquête a été réalisée on line, comme la majorité des sondages depuis quelques années. Ce mode de recueil est particulièrement adapté à ce type de sujets, à l’opposé des sondages par téléphone ou en face-à-face, où une partie des interviewés n’ose pas dévoiler ses opinions à l’enquêteur de peur qu’elles soient jugées comme étant illégitimes ou « politiquement incorrectes ». En ce sens, cette étude portant sur les théories du complot et le rapport au « Système », il nous est apparu tout à fait judicieux de recourir à une enquête on line dans laquelle le sondé peut s’exprimer en totale liberté devant son écran sans craindre d’être jugé par un enquêteur.” [Jérôme Fourquet]

Cependant, on peut tout autant supposer que, sur ce genre de questions pouvant sembler peu sérieuses (pensez-vous que la terre est plate ?), le fait de ne pas avoir un interlocuteur physique pourrait aussi inciter des personnes à répondre n’importe quoi à des questions qui peuvent sembler peu sérieuses. Soulignons aussi que, si la majorité des sondages utilise désormais cette méthode par Internet, c’est surtout car c’est moins cher, et que les sondés par téléphone répondent de moins en moins aux sondeurs…

On noter également que ce sondage a posé 37 questions aux sondés ! Or, certains spécialistes des sondages estiment qu’après une vingtaine de questions, l’attention des sondés peut commencer à s’émousse.

Plus précisément, le déroulé du sondage a apparemment consisté en :

- 14 questions diverses (dont certaines sur le réchauffement climatique ou le 11 Septembre) ;

- 11 questions testant la notoriété de “différentes théories complotistes” ;

- 11 de plus testant l’adhésion à ces dernières ;

- et une finale sur les attentats de janvier 2015.

II. Les 11 “différentes théories complotistes”

Nous commençons avec ce point, car c’est celui qui a “buzzé” dans les médias.

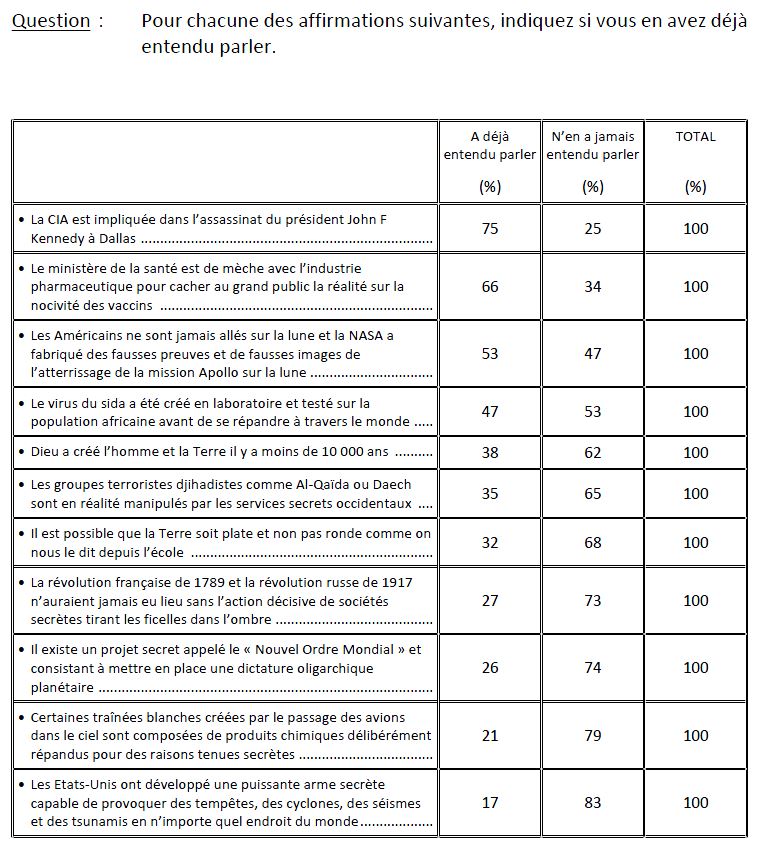

Mais rappelons bien qu’à ce stade, on a des sondés seuls, face à leur PC, et déjà déconcentrés par la quinzaine de questions précédentes. Voici les 11 “théories”:

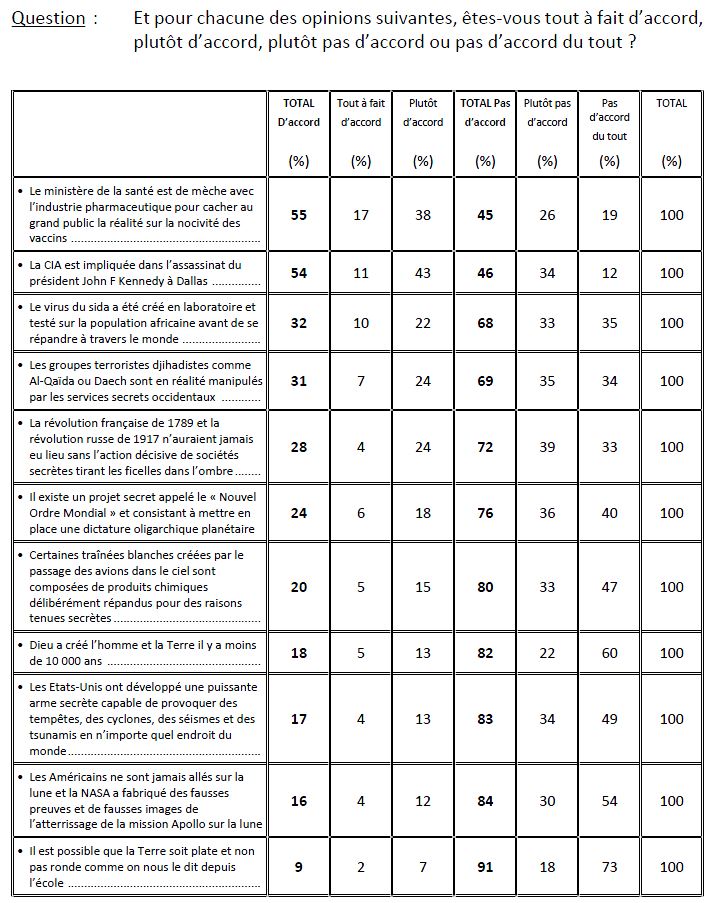

Après avoir obtenu ces 11 réponses quant à la notoriété des théories, on redemande aux sondés s’ils y adhèrent :

Il y a énormément à dire sur tout ceci. (Je précise, vu le contexte, que je n’aurais personnellement répondu oui à aucune de ces 11 questions).

Plusieurs problèmes méthodologiques majeurs sautent aux yeux.

Le premier point problématique évident est qu’il y a une claire volonté d’enfermer les sondés, car il n’y a pas de possibilité de ne pas répondre à une question : il manque l’indispensable “Sans opinion”. Pourtant, le sondeur assume :

“Le questionnaire ne prévoyait pas de « ne se prononce pas »

Le questionnaire comprenait pour l’essentiel des questions de notoriété et d’approbation. Pour ce qui est de la notoriété (« avez-vous déjà entendu parler ou non ? »), le « ne se prononce pas » ne fait pas sens et ne s’impose pas. De la même façon, pour la question d’approbation, compte tenu de la nature des items proposés, il nous a semblé que les interviewés seraient en mesure de se positionner assez aisément sur une échelle d’approbation et d’indiquer s’ils étaient d’accord ou pas avec ces assertions. Afin de nuancer le jugement et d’exprimer les doutes, une échelle en quatre points a été retenue : tout à fait d’accord, plutôt d’accord, plutôt pas d’accord et pas d’accord du tout.” [Jérôme Fourquet] (Source)

Pourtant, on peut soutenir que, même pour la notoriété, il est indispensable de disposer d’un “ne se prononce pas”. D’une part, par simple déontologie, pour laisser au sondé la liberté de ne pas répondre, et d’autre part, car les énoncés sont extrêmement confus, mélangent plein de choses, et peuvent donc susciter le doute chez le sondé (que répondra le sondé s’il a entendu parler de la théorie d’un deuxième homme ayant tué Kennedy, mais s’il ne sait plus si celui-ci faisait partie ou non de la CIA ?).

Ensuite, la réponse “ne se prononce pas” est évidemment indispensable quant à l’adhésion aux théories, surtout lorsqu’on considère que, pour la plupart, et dans 50 % à 80 % des cas, le sondé n’a jamais entendu parler de la théorie.

Deuxième point problématique : le choix de l’échelle d’approbation vantée par Jérôme Fourquet. Face à ces théories loufoques, les sondés étaient donc obligés de se prononcer sur 4 items : 1/ Tout à fait d’accord 2/ Plutôt d’accord 3/ Plutôt pas d’accord 4/ Pas d’accord du tout. C’est une forme réduite de l’échelle dite “de Likert”, en l’espèce à 4 points. Là encore, non seulement on force le sondé à répondre, mais on le force à choisir un des deux camps “pour” ou “contre”, alors qu’il a généralement indiqué ne pas connaitre la théorie. En plus de la réponse “Sans opinion”, il manque donc un point milieu : “Neutre” ou “Ni d’accord, ni pas d’accord”.

C’est très important, car les chercheurs Alwin et Krosnick (dans « The Reliability of Survey Attitude Measurement: The Influence of Question and Respondent Attributes », Sociological Methods Research, vol. 20, no 1, 1991) ont noté que l’absence d’un tel point milieu diminue la fiabilité de l’échelle, le sondé en étant réduit à choisir au hasard un des deux points encadrant le point milieu omis. Ils recommandent également des échelles en 7 points. (Source) Plus récemment, une étude (Maydeu-Olivares, Alberto, Fairchild, Amanda J. et Hall, Alexander G., « Goodness of Fit in Item Factor Analysis: Effect of the Number of Response Alternatives », Structural Equation Modeling: A Multidisciplinary Journal, vol. 24, no 4, 2017, ) ayant eu recours à de la simulation numérique, a mis en évidence qu’utiliser un nombre trop réduit de graduations (3 ou 5) pouvait conduire à des modèles d’analyse factorielle confirmatoire ne détectant pas des anomalies de spécification ou de distribution introduites volontairement. Les auteurs suggèrent donc un optimum de 7 ou 9 points. On est donc loin du compte avec cette échelle de 4 points.

Troisième point problématique : le principe même de l’échelle d’approbation. Comme le souligne le remarquable Observatoire des sondages dans un billet dédié à ce sondage Ifop :

“On touche là l’un des points les plus fantaisistes et critiques du sondage. Cette méthode rustique est utilisée fréquemment dans les enquêtes de satisfaction. Elle est totalement inadaptée pour mesurer des distinctions significatives entre les degrés d’accord ou de désaccord à des propositions un peu complexes ou sensibles. Illustration : que signifie précisément être plutôt d’accord avec : « le ministère de la santé est de mèche avec l’industrie pharmaceutique pour cacher au grand public la réalité sur la nocivité des vaccins » ? Les sondeurs le savent, en privilégiant cette réponse des sondés peuvent vouloir exprimer des doutes. Lesquels ? Le sondeur s’en moque. Tant pis. C’est ce qui la différencie néanmoins d’un « tout à fait d’accord avec ». Le sondeur s’en moque là aussi et fait comme si les deux types de réponses n’en était qu’une, il les additionne. « L’échelle de Likert » est donc un leurre. Il fallait oser, mais les coups de force sont rarement subtils.” [Observatoire des sondages]

Quatrième point soulevé : comme le rappelle l’Observatoire des sondages, il est très fortement contestable d’avoir additionné les “Tout à fait d’accord” et les “Plutôt d’accord”. On a ainsi embarqué ensemble dans la case “complotistes” des personnes qui déclarent croire dur comme fer à des théories loufoques et d’autres personnes qui ont simplement émis un doute (peut-être d’ailleurs, très léger, mais l’échelle retenue ne le mesure pas) sur une théorie dont ils n’ont, pour la plupart, jamais entendu parler !

D’ailleurs, que peut bien signifier ce “Plutôt d’accord” pour la plupart des sondés ? Ils ont marqué clairement qu’ils n’étaient pas “Tout à fait d’accord”. Mais veulent-ils dire qu’ils y croient un peu, qu’ils doutent de la fausseté de la réponse, qu’ils ne savent pas bien, qu’ils n’y croient pas, mais qu’ils jugent simplement que c’est en théorie possible ? Qu’il reste des zones d’ombre ? Mystère…

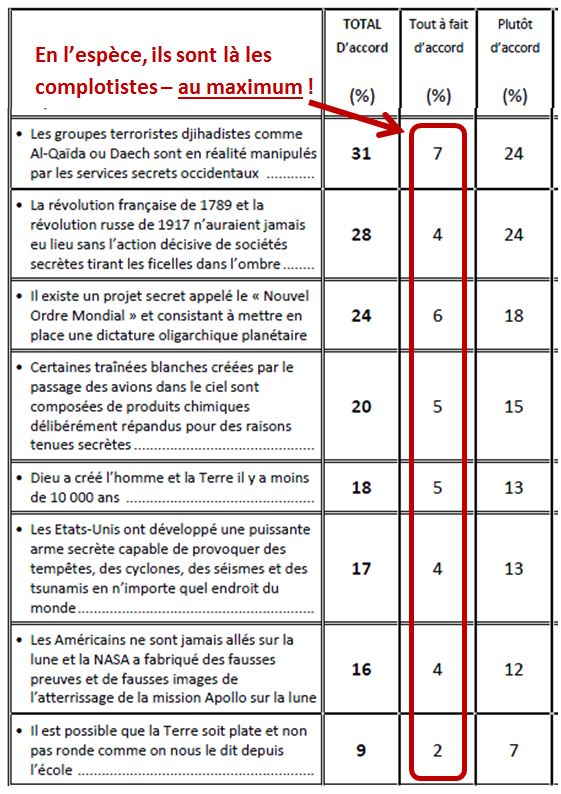

Ainsi, pour peu que cette notion ait un sens (nous y reviendrons), c’est bien dans les “Tout à fait d’accord” que Rudy Reichstadt devrait surtout chercher les “complotistes”. Mais c’est là qu’il a eu un gros problème :

Le souci, c’est que les vrais “complotistes”, il n’y en très pas… Le phénomène reste totalement marginal.

Et encore, ces chiffres sont des majorants, car faut-il encore être sûr que les sondés ne se sont pas moqués du sondeur, ou qu’ils ont bien répondu honnêtement et sérieusement…

Sachant, enfin, que si l’échantillon du sondeur est vraiment représentatif, on va également obtenir des réponses de personnes souffrant de troubles psychiatriques altérant leur discernement ou simplement leur humeur (une dizaine de pour cents de la population selon la Drees). Ceci va à l’évidence rendre difficile dans tous les cas d’obtenir un taux de ‘complotistes” présumés (suivant ces définitions extensives) inférieur à un plancher de probablement 1 à 4 %…

Mais nous reviendrons sur ce point.

Cinquième point problématique : les sondés ne connaissant pas certaines théories ont été obligés de se prononcer. La majorité des sondés a donc souvent dû se prononcer en quelques secondes – après déjà une vingtaine de réponses – sur leur adhésion à une théorie qu’ils ne connaissaient pas, en se basant seulement sur la ligne d’énoncé de la question, souvent confuse. Mais là encore, le sondeur assume :

“Les sondés ont été amenés à se positionner sur des thèses ou opinions qu’ils ne connaissaient pas :

L’architecture du questionnaire était conçue en deux temps. On mesurait tout d’abord la notoriété de différentes théories pour évaluer quel était le niveau de diffusion de chacune d’elles. On sait en effet que ces théories circulent sur le mode viral et il était donc intéressant de pouvoir quantifier thème par thème combien de Français avaient déjà entendu parler du sujet en question.

Dans un second temps, que les interviewés en aient déjà entendu parler ou non, ils étaient appelés à exprimer leur niveau d’adhésion à chacune des thèses testées. Il s’agissait d’évaluer le crédit apporté à ces théories ou opinions et la propension des Français à y adhérer spontanément. Même sans avoir déjà vu, lu ou entendu cette thèse, les sondés nous semblaient pleinement en mesure d’indiquer dans le cadre de l’enquête si telle ou telle thèse leur paraissait crédible ou plausible.

Quand l’enquête indique par exemple que 20 % des Français se disent d’accord avec la thèse des « Chemtrails » (sur les traînées blanches laissées dans le ciel par les avions), nous n’en concluons pas qu’un Français sur cinq a déjà entendu parler de cette idée et la partage mais que, confrontée à cet argument, une personne sur cinq y adhère spontanément.” [Jérôme Fourquet] (Source)

Donc Monsieur Fourquet ne répond pas au problème méthodologique, et se contente d’indiquer que “les sondés nous semblaient pleinement en mesure d’indiquer […] si telle ou telle thèse leur paraissait crédible ou plausible”. On en appréciera la rigueur scientifique. Plus intéressante encore est la précision qu’il apporte : “nous n’en concluons pas [que les gens] partagent [cette idée] mais que [ils] y adhèrent spontanément”. On peine à comprendre le fond exact de son propos (partage / adhérer ?), mais, dans tous les cas, l’idée générale est démentie par les faits, puisqu’il a regroupé toutes ces personnes ensemble pour scinder la population entre “complotistes” et “non complotistes”.

Sixième point problématique : la formulation des questions. La plupart des questions posées sont mal rédigées, ambiguës, trompeuses, pousse au crime voire totalement inexploitables. Analysons ceci.

Il est intéressant de savoir si les réponses affichées sont bien le reflet de la pensée réelle des sondés et d’essayer de comprendre ce qui aurait incité les sondés à répondre positivement à celles-ci.

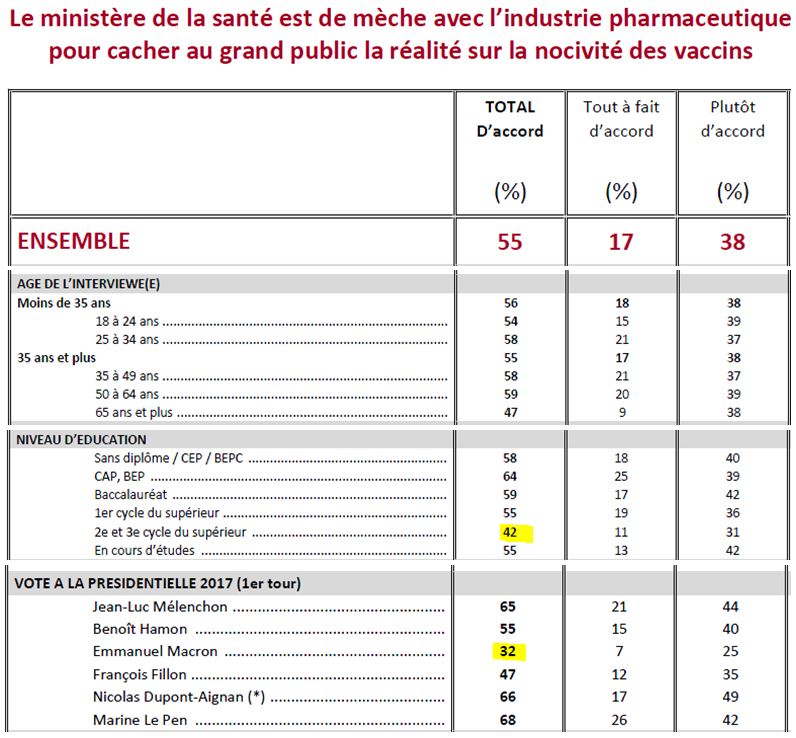

1. Le ministère de la Santé est de mèche avec l’industrie pharmaceutique pour cacher au grand public la réalité sur la nocivité des vaccins (17 % de pleine adhésion)

Question peu exploitable. Dans le contexte actuel, on mélange dans question deux idées différentes :

A/ Le ministère de la Santé est de mèche avec l’industrie pharmaceutique : question d’intégrité politique

B/ On cache au grand public la réalité sur la nocivité des vaccins : question de santé

Il apparaît qu’on aurait en fait pu – et dû – poser deux questions, ciblant chacune un des deux axes : 1-1 : “Le ministère de la Santé est de mèche avec l’industrie pharmaceutique pour augmenter le chiffre d’affaires de cette dernière” 1-2 “Le ministère de la Santé cache sciemment au grand public la réalité de la grande nocivité des vaccins” ou “Le corps médical cache sciemment au grand public la réalité de la grande nocivité de certains vaccins”.

Notons aussi qu’il existe des exemples passés venant soutenir une partie de ces questions : sang contaminé, scandales à répétition dans l’industrie du médicament, vaccination Bachelot de 2009, Médiator, Depakine, Glyphosate… La nouvelle ministre s’est même félicitée par le passé de l’existence de conflits d’intérêts majeurs (Source) – comment s’étonner de la perte de confiance ensuite (Source) ?

Il est évident qu’en choisissant de tout mélanger dans la question aux sondés, on s’exposait à ce qu’ils s’arrêtent à une partie de la question qui peut les scandaliser, et, contraints de répondre et de choisir un camp, qu’ils aient basculé du mauvais côté assez facilement. D’où la proportion élevée – mais qui ne dépasse pas 17 % au maximum de réelle adhésion.

Enfin, il y a quelques informations intéressantes à tirer de cette question (même si elle a très vraisemblablement été mal comprise par les sondés, et simplement vue comme une question sur la compromission des pouvoirs publics avec les industriels) :

On observe donc que pour cette question, et contrairement à la plupart des autres, il n’y a pas de véritables écarts suivant l’âge ni suivant le niveau d’éducation, à l’exception des personnes très éduquées. On peut donc se demander si, au-delà seulement d’une meilleure compréhension de la question (les personnes du 1er cycle du supérieur ayant aussi probablement une bonne compréhension), il n’y aurait pas aussi chez ces “classes supérieures”, souvent sélectionnées par leur conformisme scolaire voire social, une plus grande imperméabilité au doute et à l’esprit critique. Ce qu’Emmanuel Todd a souligné en disant que :

“La révolution inégalitaire a pris sa source dans l’éducation supérieure […] L’alphabétisation universelle, base de la démocratie moderne, est, quoi qu’en disent certains déclinistes, toujours en place, mais il s’y est superposé une division de la société en « ordre méritocratiques » primaire, secondaire et supérieur. L’ordre supérieur est lui-même finement gradué par les niveaux de prestige des divers diplômes et titres universitaires. La sélection méritocratique ne peut, en effet, fonctionner sans la base d’alphabétisation dont est extrait l’ordre des supérieurs. Les sociétés avancées doivent donc vivre sous tension : l’éducation primaire universelle nourrit inlassablement la possibilité de la démocratie, l’éducation supérieure approvisionne non moins inlassablement une classe supérieure qui, parce qu’elle est sélectionnée par le mérite, se pense intellectuellement et moralement supérieure en droit. Cette supériorité est une illusion collective : l’homogénéité et le conformisme engendrés par le mécanisme de sélection produisent le paradoxe ultime d’un monde d’en haut sujet au repliement intellectuel, faiblement apte à la pensée individuelle. C’est ainsi qu’en un sens sociologique, on peut dire que le monde d’en haut est idiot et peu moral.” [Emmanuel Todd, Où en sommes-nous ?]

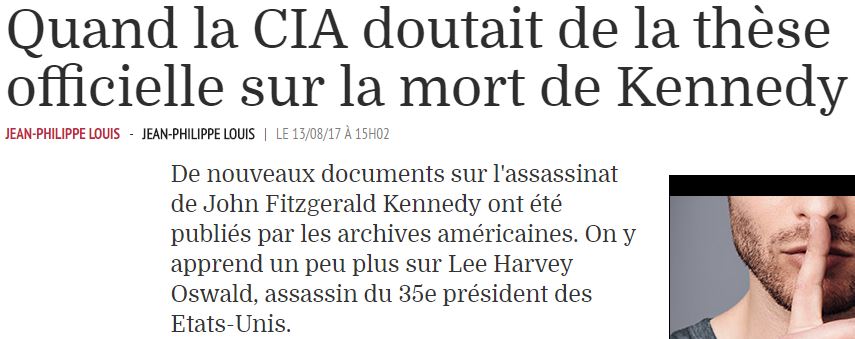

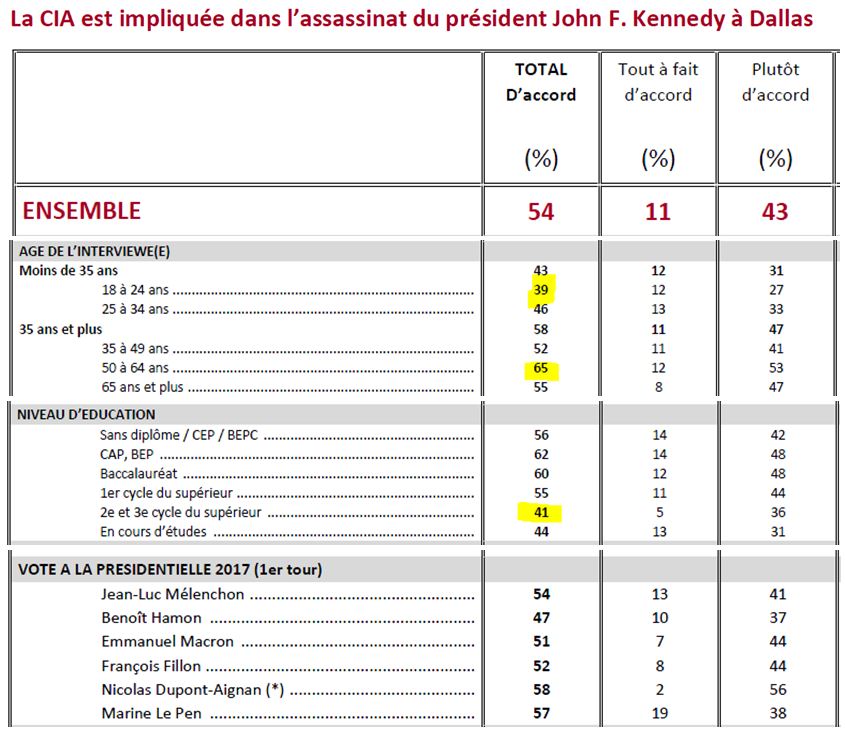

2. La CIA est impliquée dans l’assassinat du président John F. Kennedy à Dallas (11 % de pleine adhésion)

Même si c’est moins flagrant, la question est encore non exploitable, car on a finalement mélangé deux idées différentes :

A/ Lee Harvey Oswald n’a pas agi seul, il y avait un deuxième tireur : il y avait un complot pour tuer Kennedy, toute la lumière n’a pas été faite

B/ La CIA est impliquée

On aurait également encore pu poser deux questions pour mieux cibler ce que pensaient les gens, avec en particulier : “Un deuxième tireur à visé JFK, Oswald n’a pas agi seul” (qui aurait pu être un complice d’Oswald, de la mafia, de Cuba ou de ce qu’on voudra).

Soulignons qu’on teste ici une théorie qui est certes célèbre, mais qui concerne un autre pays. La grande majorité des sondés ne maîtrise clairement pas l’étendue du sujet, et des débats aux États-Unis.

Comme la presse en rajoute régulièrement, et qu’on a reparlé de l’affaire en 2017, il est peu surprenant d’arriver à un score élevé de Français qui doutent (Sources : ici, ici et là) :

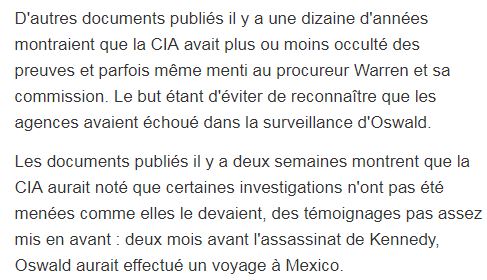

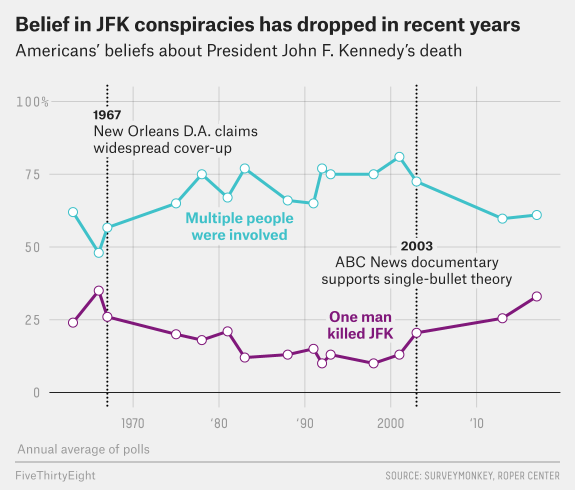

Comment pourrait-il en être autrement, sachant qu’aux États-Unis, les Américains rejettent à plus de 60 % l’hypothèse “Oswald comme unique tireur” (Source) :

Notez que le sondeur américain a su poser correctement la question, exprimée clairement et ne testant qu’une hypothèse à la fois, sans aller chercher des “Plutôt d’accord” : “Estimez-vous que, dans l’assassinat de JFK, il y avait un seul assassin, ou alors que d’autres personnes sont impliquées ?”

Et encore, plus le temps passe, moins les gens croient à cette hypothèse (Source) :

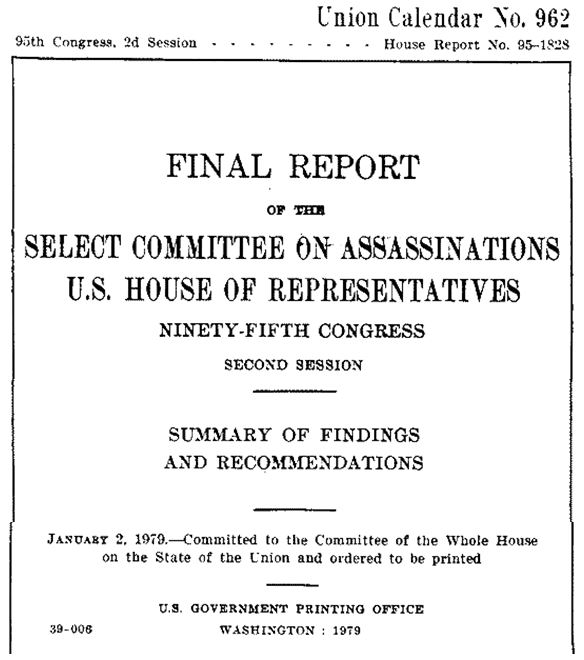

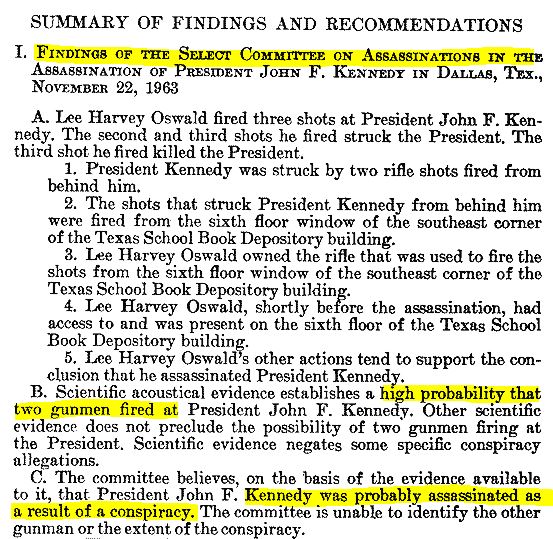

Là encore, peu surprenant pour les États-Unis, car un rapport parlementaire officiel de 1979 a même évoqué cette piste (précisons très clairement que ces éléments ont été très fortement remis en question ensuite, lire ici et ici) – mais il est donc peu étonnant que les gens doutent ensuite… On voit qu’on a ici une théorie du complot qui n’est pas du tout au même niveau que des théories de type “reptiliens” ou “la terre est plate”.

Plus précisément, on s’aperçoit ici que les jeunes sont nettement moins réceptifs à cette théorie, à l’instar – à nouveau -, des plus éduqués :

Mais au final, on peut aussi se demander quel est l’intérêt concret de poser cette question, si ce n’est d’avoir une théorie “complotiste” avec un haut score. D’autant que la CIA a été impliquée dans plusieurs assassinats ou tentatives d’assassinats de dirigeants étrangers, il y a peut-être des choses plus urgentes à analyser…

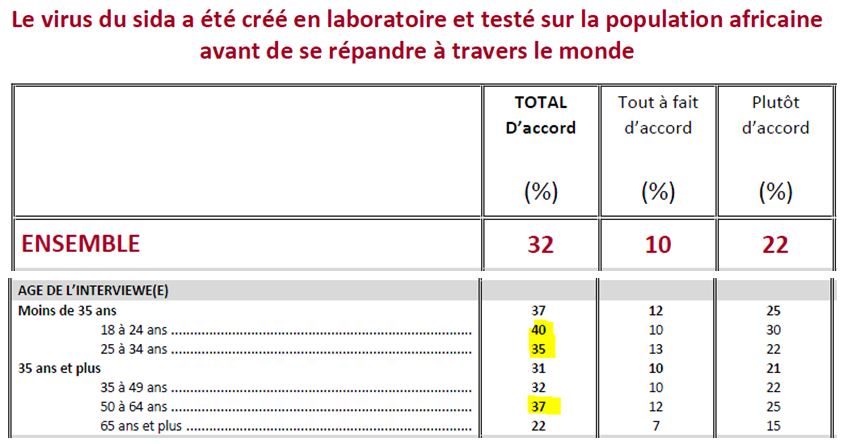

3. Le virus du sida a été créé en laboratoire et testé sur la population africaine avant de se répandre à travers le monde (10 % de pleine adhésion)

Cette question teste cette fois 3 sous-sujets :

A/ Le virus du sida a été créé en laboratoire

B/ Le virus du sida a été testé sur la population africaine

C/ Le virus du sida s’est répandu à travers le monde

La question aurait gagné à être allégée, un peu dans ce style : “Le virus du Sida a été créé volontairement dans le but de contaminer l’espèce humaine”

Là encore, impossible de savoir ce qui a vraiment été déterminant dans la réponse des sondés.

On note aussi qu’il y a peu de différence “d’adhésion” entre les différentes personnes en activité professionnelle :

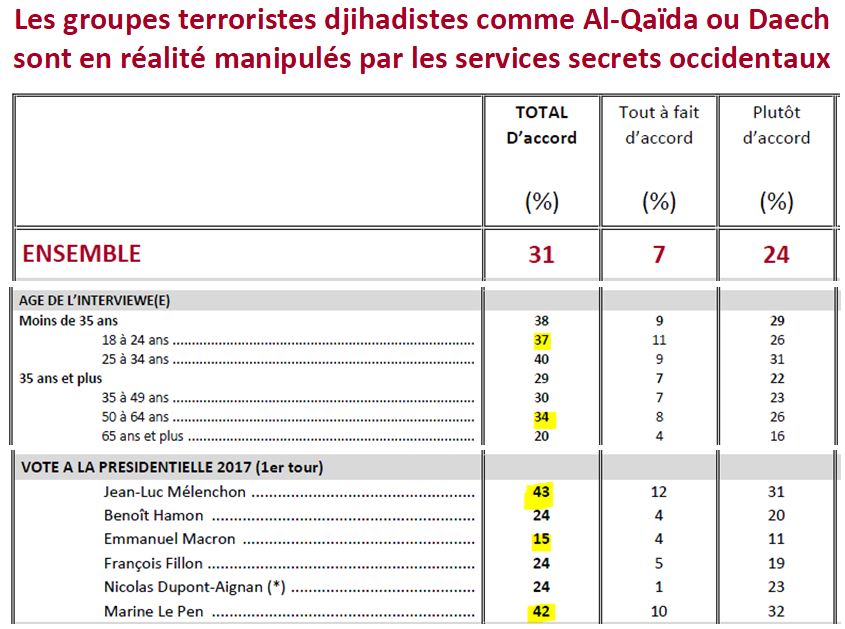

4. Les groupes terroristes djihadistes comme Al-Qaïda ou Daech sont en réalité manipulés par les services secrets occidentaux (7 % de pleine adhésion)

On a enfin une question unique. Mais, pas de chance, elle contient 2 lourdes erreurs de formulation :

a) “Les groupes terroristes djihadistes comme Al-Qaïda ou Daech” : du coup on ne sait pas de qui on parle, puisqu’on n’a pas limité à Daech. Dans les “groupes terroristes djihadistes”, on a donc par exemple des rebelles djihadistes syriens à qui l’Occident à clandestinement livré des armes…

b) “manipulés” : quel est le sens exact ? Qu’ils obéissent au doigt et à l’oeil directement à la CIA ? Que la CIA y a infiltré quelques agents ? Que la CIA leur fait simplement livrer des armes de façon clandestine ? Que la CIA aide des pays qui soutiennent ces groupes ? Cela fait un éventail potentiellement très large.

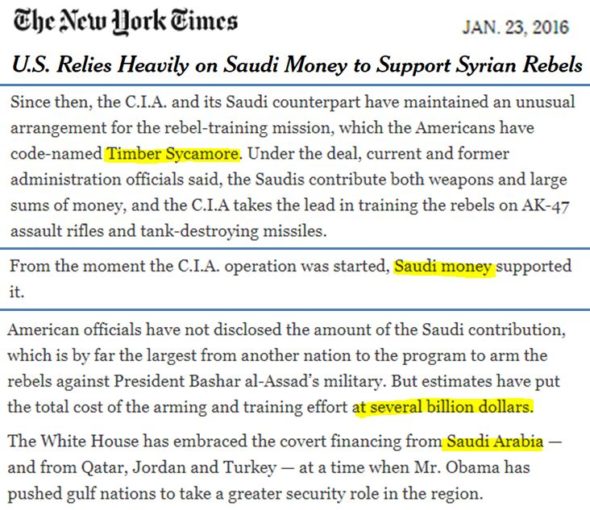

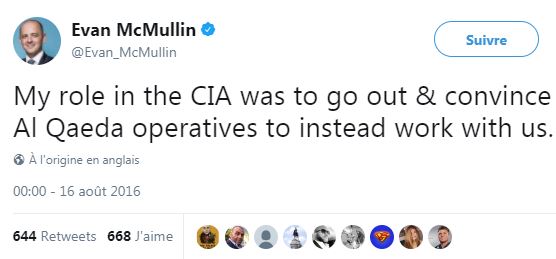

Si rien ne vient soutenir une réponse fermement positive à la question posée, il est tout à fait possible que des personnes qui doutent un minimum aient pu être influencées par certains éléments. Comme l’opération Timber Sycamore de la CIA (révélée par le New York Times en 2016) qui a apporté beaucoup de soutien à bon nombre de djihadistes syriens :

Les sondés ont aussi pu être influencés par le fait que le Secrétaire d’État John Kerry ait reconnu dans une conversation privée qu’Obama espérait se servir de Daech comme un levier contre Assad (Source) :

Ou encore par le fait qu’Evan McMullin, ancien agent de la CIA, et ancien candidat à la présidentielle américaine ait dit ceci (source) :

Sans même parler de ce genre d’information (Source) :

Il est donc assez normal que tout ceci génère des doutes pour répondre à la question posée.

Ceci étant, notons qu’on n’est plus qu’à 7 % des sondés déclarant adhérer totalement à cette théorie.

Plus précisément :

On observe d’une part qu’il n’y a, de nouveau, pas de grosses différences “d’adhésion” entre les actifs (on rappelle que pour ces sous-groupes de taille réduite, les marges d’erreur sont nettement plus importantes, d’au moins 6 ou 8 points), mais qu’il y a une très nette différence entre les électorats Macron et Mélenchon ou Le Pen. Mais ces deux derniers candidats ayant largement dénoncé durant la campagne électorale certaines compromissions des gouvernements occidentaux avec certains groupes djihadistes syriens qu’ils ont armés, il se peut simplement que les sondés aient voulu marquer leur adhésion sur ce point, et non pas en toute rigueur à l’énoncé très précis de la question.

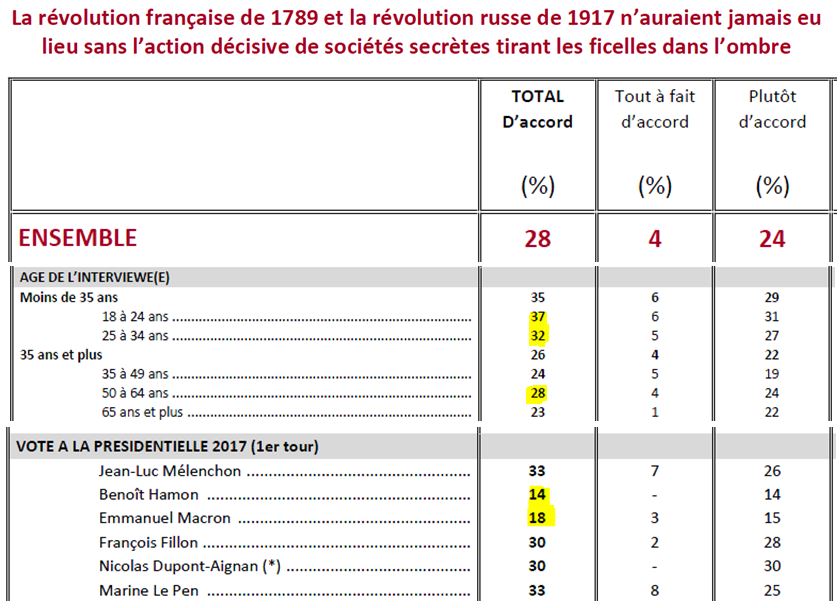

5- La révolution française de 1789 et la révolution russe de 1917 n’auraient jamais eu lieu sans l’action décisive de sociétés secrètes tirant les ficelles dans l’ombre (4 % de pleine adhésion)

Encore plusieurs sous-sujets rendant les réponses inexploitables :

A/ La Révolution française de 1789

B/ et la Révolution russe de 1917

C/ n’auraient jamais eu lieu sans l’action décisive de sociétés secrètes

D/ tirant les ficelles dans l’ombre

On mélange donc ici des événements sans le moindre lien temporel ni géographique.

Le gros problème est de ne pas avoir défini le concept de “sociétés secrètes”. Quand on s’y connait un peu en complotisme, on comprend que la question doit faire référence aux théories du genre des “Illuminatis”. Mais il est évident que le sondé moyen risque plutôt de penser dans le premier cas à des sociétés réelles, du genre clubs philosophiques, franc-maçonnerie, militants républicains, etc., et aux sociétés secrètes bolcheviques dans le second cas. Si le “tirant les ficelles dans l’ombre” n’est pas compris comme un marqueur d’une théorie complotiste, certains sondés risquent donc de répondre assez facilement “plutôt oui”…

On observe d’une part qu’il n’y a, de nouveau, pas de grosses différences “d’adhésion” entre les actifs et que pour le coup l’électorat très éduqué Macron/Hamon semble refuser durement l’idée de l’existence de “sociétés secrètes” qui, parfois, et au-delà des fantasmes, existent vraiment… (les organisations politiques secrètes bolcheviques, par exemple, à l’époque).

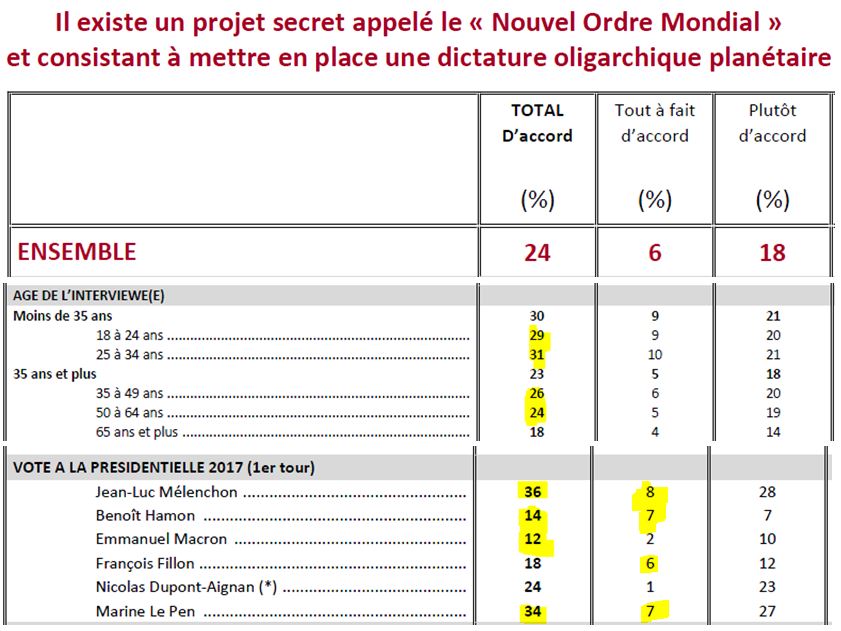

6- Il existe un projet secret appelé le « Nouvel Ordre Mondial » et consistant à mettre en place une dictature oligarchique planétaire (6 % de pleine adhésion)

Ici, la question ne teste bien qu’une seule théorie, mais elle aurait gagné à être explicitée (et d’ailleurs il n’est pas évident que tous les sondés comprennent bien le terme “oligarchique”).

Avec 6 % de pleine adhésion, on reste dans une adhésion marginale. Les “plutôt d’accord” sont certes assez élevés avec 18 %, mais là encore, l’interprétation de ceci au vu des nombreuses erreurs méthodologiques est compliquée. Ce n’est probablement qu’un sentiment diffus qu’une partie du pouvoir échappe au seul spectre politique – comme l’a rappelé Danielle Mitterrand :

« Mai 1981 fut un mois de grande activité, car c’était la préparation de l’arrivée au pouvoir de François. J’essayais d’apporter tout ce qu’il y a de meilleur en moi, pour que ce rêve d’avoir une société socialiste, quoique à l’européenne, devienne réalité. Mais bien vite j’ai commencé à voir que cette France juste et équitable ne pouvait pas s’établir. Alors je demandais à François : ‘‘Pourquoi maintenant que tu en as le pouvoir ne fais-tu pas ce que tu avais promis ?’’ Il me répondait qu’il n’avait pas le pouvoir d’affronter la Banque mondiale, le capitalisme, le néolibéralisme. Qu’il avait gagné un gouvernement mais non pas le pouvoir. J’appris ainsi qu’être le gouvernement, être président, ne sert pas à grand-chose dans ces sociétés sujettes, soumises au capitalisme. J’ai vécu l’expérience directement durant quatorze ans. Même s’il essayait d’éviter le côté le plus négatif du capitalisme, les rêves ont commencé à se briser très rapidement. […] En France, on élit et les élus font des lois qu’ils n’ont jamais proposées et dont nous n’avons jamais voulu. […] La France est-elle une démocratie ? Une puissance mondiale ? Je le dis en tant que Française : cela ne veut rien dire ». [Danielle Mitterrand, interviewée par Hernando Calvo Ospina, 2005 – source]

On observe qu’il y a de nouveau des différences “d’adhésion” en fonction de l’orientation politique. Mais là encore, difficile de savoir si les sondés répondent très clairement à la question, ou s’ils expriment des craintes face à une forme d’oligarchie dépossédant le peuple de ses prérogatives (cf. référendum de 2005, qui ne peut que laisser de lourdes traces dans la confiance envers les dirigeants). Là encore, le coeur de l’adhésion est marginal. On note des différences marquées politiquement, mais ceci est probablement à rapprocher au fait que l’oligarchie (hors théories du complot) est un terme plus employé et discuté dans les partis concernés.

On observe également qu’il n’y a, de nouveau, pas de grosses différences “d’adhésion” en fonction de l’âge. À ce stade, on peut donc noter que sur ces 6 premières “théories” qui recueillent de très loin le plus “d’adhésion” (et qui doivent représenter environ 70 des 80 % des sondés que l’enquête a classé comme “croyants” à “au moins une théorie du complot”, il est clair qu’il n’y a en réalité guère d’influence de l’âge, au moins avant 65 ans. Et qu’il est erroné de laisser penser qu’une vaste majorité des jeunes seraient des “complotistes”. Ce sont les questions suivantes qui ont contribué à brouiller cette claire vision.

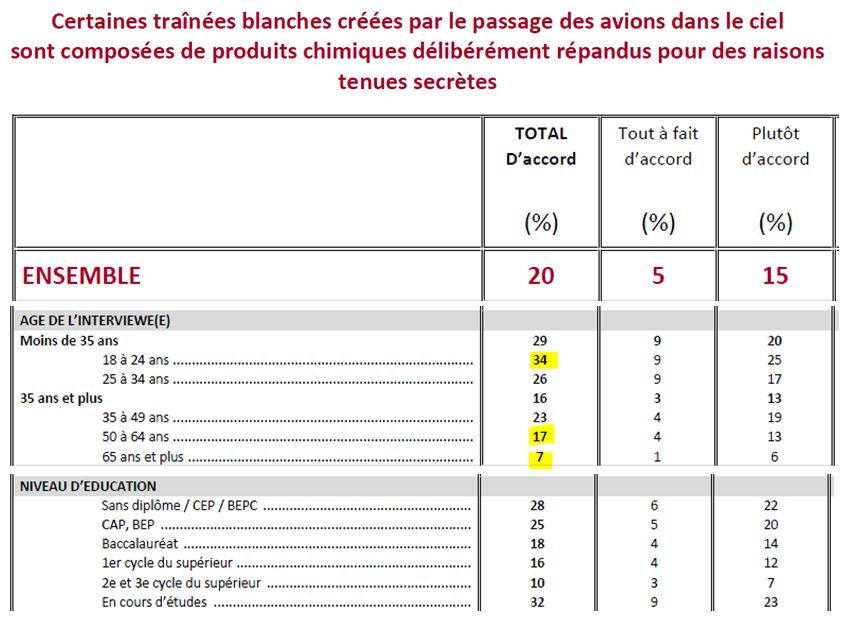

7- Certaines traînées blanches créées par le passage des avions dans le ciel sont composées de produits chimiques délibérément répandus pour des raisons tenues secrètes (5 % de pleine adhésion)

Encore plusieurs propositions apparaissent, ce qui rend les réponses difficilement exploitables :

A/ Certaines traînées blanches créées par le passage des avions dans le ciel sont composées de produits chimiques

B/ délibérément répandus

C/ pour des raisons tenues secrètes

Pour qui s’intéresse au complotisme, c’est une claire allusion aux rares théories (ubuesques) autour des traînées des avions dites des “chemtrails” (traînées chimiques). On parle ici des traînées naturelles de condensation des avions (“contrail“); ce phénomène, qui ne se produit que dans des conditions particulières de température (-40°C) et d’humidité (donc à de très hautes altitudes, de 8 à 10 km), est simplement dû au fait que la vapeur d’eau très chaude des gaz d’échappement des réacteurs se retrouve brutalement en contact avec l’atmosphère très froide, et se cristallise instantanément (c’est-à-dire que la vapeur passe directement de l’état gazeux à l’état solide, sans passage par l’état liquide). En fait, dans de telles conditions météorologiques, les réacteurs de l’avion créent simplement des nuages de glace… (Pour les chimistes dans l’âme, la combustion du kérosène C10H22 en présence d’oxygène produit beaucoup de vapeur d’eau et de gaz carbonique, suivant la formule 2 C10H22 + 31 O2 → 20 CO2 + 22 H2O).

Mais comme les traînées des réacteurs peuvent très vaguement ressembler à des traînées d’épandage aérien de produits chimiques…

…certaines personnes ont émis des théories selon lesquelles les traînées des réacteurs dispersaient en fait des produits chimiques pour : empoisonner la population (ou la contrôler, ou la stériliser…), faire des tests d’armes chimiques ou biologiques, changer le climat, empêcher la population de voir les OVNI (on en passe, et des meilleures).

Rappelons qu’on parle de théories qui ont dans les 20 % de notoriété. La vaste majorité des sondés n’en a jamais entendu parler, et doit se référer seulement à intitulé de la question, qui est trompeur. Car si les traînées sont essentiellement constituées de vapeur d’eau, elles comprennent évidemment aussi des traces des gaz d’échappement, qui contiennent donc bien des produits chimiques ! Donc si on reprend la question de Conspiracy Watch

A/ Certaines traînées blanches créées par le passage des avions dans le ciel sont composées de produits chimiques : c’est VRAI (“Ces traînées contiennent aussi des aérosols de particules émises par les réacteurs, dont du noir de carbone et des sulfates” – source)

B/ délibérément répandus : c’est VRAI

C/ pour des raisons tenues secrètes : c’est le seul point qui est FAUX, car on en connait parfaitement la raison, c’est pour faire avancer l’avion…

Il est à craindre que beaucoup de personnes n’aient pas fait ce distinguo… Une question du genre “Les traînées blanches créées par le passage des avions dans le ciel sont en fait des épandages volontaires de produits chimiques visant à stériliser la population.” aurait eu le mérite de la clarté – mais il est hélas probable que cela ferait perdre sa raison d’être au commanditaire du sondage vivant dans le fantasme d’un complotisme généralisé…

C’est la première question qui présente une claire différence entre les âges. Elle apparaît aussi avec le niveau d’éducation. L’énoncé étant “peu complotiste”, et la théorie testée très peu connue, il n’est donc pas évident de savoir si la question a en réalité testé le “complotisme” ou bien simplement “l’ignorance”. D’autant que, évidemment, l’ignorance de faits scientifiques assez simples mais peu connus, a tendance à diminuer avec l’âge : cela s’appelle l’apprentissage…

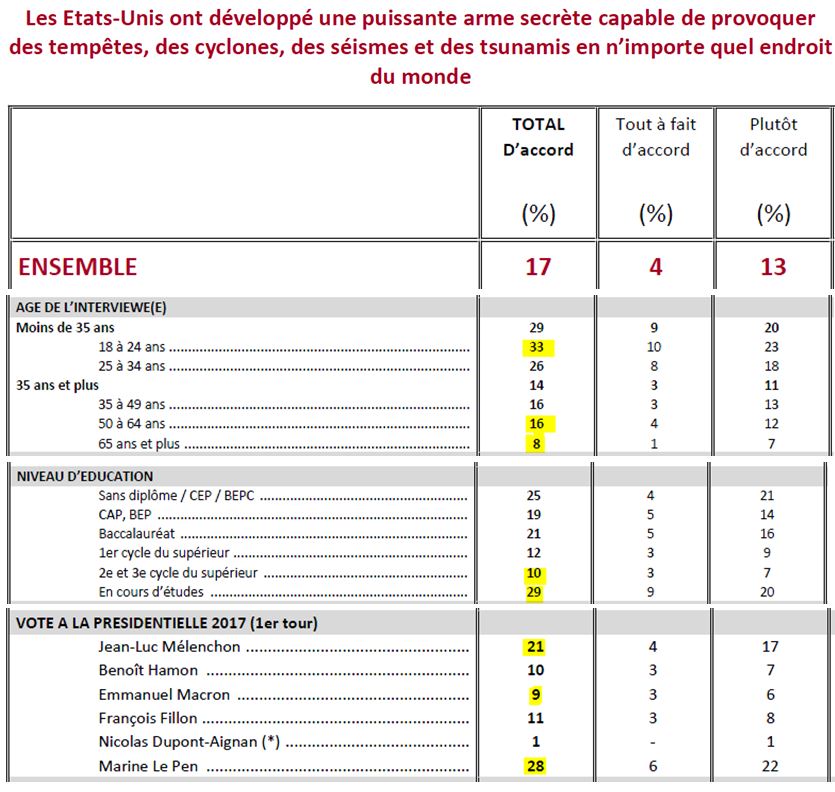

9- Les États-Unis ont développé une puissante arme secrète capable de provoquer des tempêtes, des cyclones, des séismes et des tsunamis en n’importe quel endroit du monde (4 % de pleine adhésion)

Nouvelle question mal posée, qui contient plusieurs éléments :

A/ Les États-Unis

B/ ont développé une puissante arme secrète

C/ capable de provoquer des tempêtes, des cyclones, des séismes et des tsunamis en n’importe quel endroit du monde

On commence une question scientifique par les mots “les États-Unis”, pays qui peut déclencher de vives réactions épidermiques chez certaines personnes (comme “la Russie” en déclenche chez d’autres). Il aura fallu se concentrer uniquement sur l’aspect scientifique, avec, par exemple : “Il existe des armes secrètes capables de provoquer des tempêtes, des cyclones, des séismes et des tsunamis en n’importe quel endroit du monde”, pour gommer le premier biais.

De plus, avec 17 % de notoriété et 4 % d’adhésion, on rentre une zone où on teste des théories ridicules et totalement marginales. Il est difficile de se plaindre ensuite de résultats aberrants…

On voit de nouveau que les jeunes sont surreprésentés ici. Mais adhérent-ils vraiment à la théorie (et alors, sont-ils “complotistes” ou simplement “ignorants” ?) ? Ou se moquent-ils du sondeur, ou expriment-ils un violent rejet des États-Unis, comme pourrait le laisser penser leur orientation politique ?

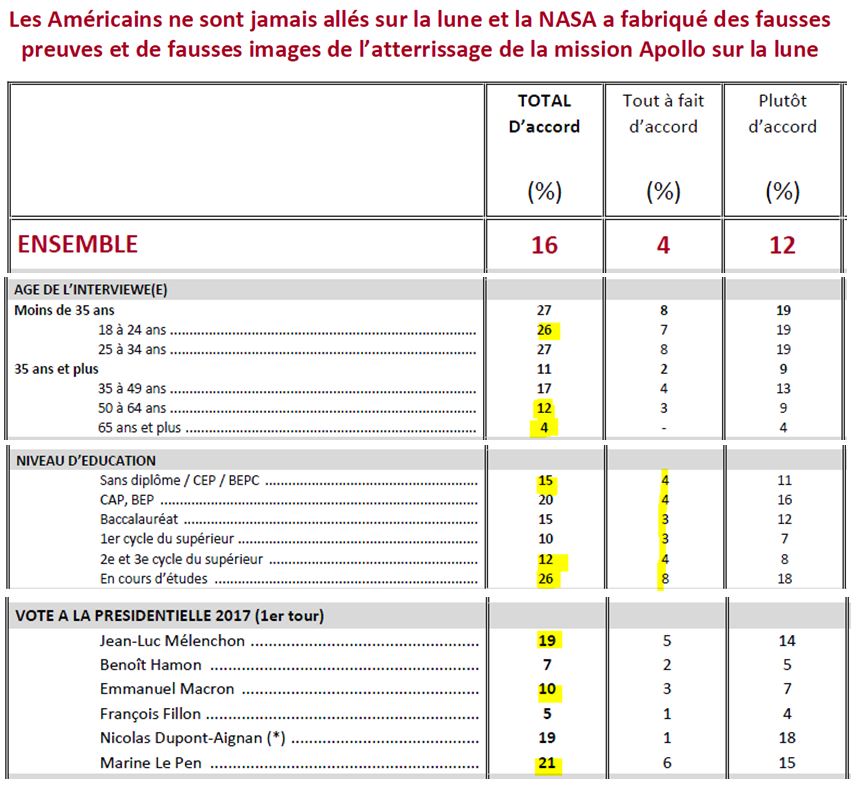

10- Les Américains ne sont jamais allés sur la lune et la NASA a fabriqué des fausses preuves et de fausses images de l’atterrissage de la mission Apollo sur la lune (4 % de pleine adhésion)

La question comporte de nouveau 2 voire 3 éléments distincts :

A/ Les Américains

B/ ne sont jamais allés sur la lune

C/ et la NASA a fabriqué des fausses preuves et de fausses images de l’atterrissage de la mission Apollo sur la lune

De nouveau, les premiers mots de la question sont “Les Américains”, phénomène renforcé par le terme “la NASA”, tout ceci pouvant fausser les réponses de certains sondés.

Les deux derniers éléments sont assez proches, mais on a toujours le risque d’avoir des personnes qui pensent que les Américains sont déjà allés sur la Lune mais que la NASA peut faire des faux par malhonnêteté. Mais oublions ce point.

On peut se demander si la question “pensez-vous que des hommes ont déjà réellement posé le pied sur la Lune ?” n’aurait pas été une question plus pertinente.

Là encore, on a une question totalement marginale, mais dont le doute est très clivé par l’âge et par le niveau d’étude, qui sont difficiles à interpréter.

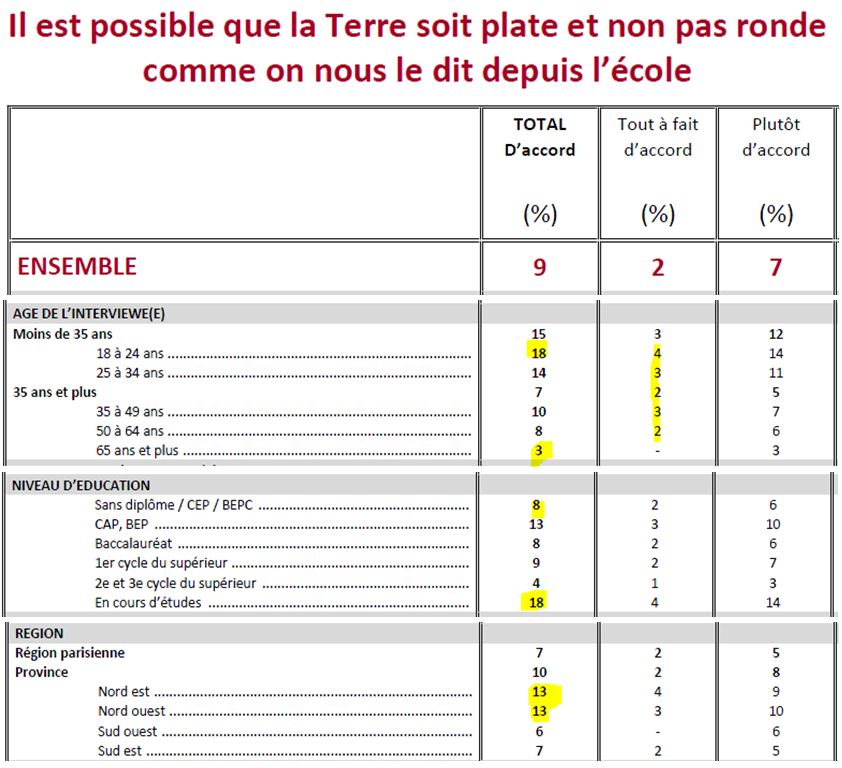

11- Il est possible que la Terre soit plate et non pas ronde comme on nous le dit depuis l’école (2 % de pleine adhésion)

Enfin la dernière question, qui a été une des plus commentées par les médias, alors qu’elle n’a que 2 % d’adhésion réelle, ce qui est le niveau de la marge d’erreur (si ce n’est le niveau de personnes à la personnalité psychiatriquement troublée de façon assez lourde). Mais désormais “ce que pensent les fous” semble être devenu quelque chose de très important pour certains journalistes. PRÉCISION : si pour le coeur du “complotisme”, je parle, par image, de “fous”, je pense aux gens qui croient, par exemple, que des Réptilens venus de l’espace complotent pour prendre le pouvoir (et qui, grâce à Internet, peuvent désormais être entendus par n’importe qui) ; toute la manipulation des “chasseurs de complotistes” autoproclamés et sans qualification consiste ensuite à essayer d’amalgamer à ceux-ci des gens qui se posent simplement des questions raisonnables…

En outre, même sur un sujet aussi simple, la question a réussi à être mal posée :

A/ Il est possible

B/ que la Terre soit plate et non pas ronde

C/ comme on nous le dit depuis l’école

On sait très bien que commencer une question par “il est possible” risque d’augmenter le nombre d’adhésions car l’aspect conditionnel de la question lui donne des airs plus « raisonnables ». Et on note que c’est justement sur la question la plus stupide qu’a été rajoutée cette formulation, absente des 10 autres questions. C’est une nouvelle erreur méthodologique.

De plus le “comme on nous le dit depuis l’école” rallonge la question sans aucune raison, et risque de troubler certains sondés (qui en sont au moins à la 30e réponse). Ce seront bien sûr des cas marginaux, mais on mesure justement un pourcentage d’adhésion marginal…

On est ici à l’étiage statistique, probablement à la limite extrême de ce que peut mesurer un sondage sur Internet avec quelques points de marges d’erreur…

On retrouve une proportion plus élevée d’étudiants, que les médias auront donc qualifiés plus ou moins “d’imbéciles facilement manipulables”, sans se demander si, en raison de leur jeune âge, “farceurs” n’aurait pas été une explication plus crédible.

Enfin, la forte différence entre la moitié Sud et la moitié Nord du pays, qui peut difficilement se justifier, jette un nouveau trouble sur le sérieux de ces résultats…

Les questions ayant été analysées, reprenons la liste des problèmes méthodologies.

Septième point problématique : le choix des questions. Les connaisseurs de Conspiracy Watch ne seront guère étonnés par ce confusionnisme. On mélange des questions relevant d’une forme de complot avec des questions qui n’ont aucun lien avec le complotisme, mais avec le manque de connaissance, voire même de simples opinions. Quel rapport entre l’assassinat de Kennedy, la Révolution de 1917, les traînées blanches dans le ciel et la forme de la Terre ? Là encore, c’est totalement assumé :

“Différentes thèses et opinions sont testées dans cette enquête et elles ne relèvent pas toutes de la théorie du complot

Effectivement, le parti pris retenu était de brasser large et de passer en revue toute une série d’opinions et de thèses de nature différente. De notre point de vue, tous les items testés ne s’apparentent pas au même corpus idéologique et il ne s’agissait pas pour nous de pratiquer un quelconque amalgame. Le but de l’enquête était de disposer d’un état des lieux le plus exhaustif possible mais aussi de voir si l’adhésion à certaines thèses étaient corrélées (ce que prouvent les données d’enquête) avec l’approbation d’opinions sur des sujets très différents, relevant tous d’une grille de lecture alternative réfutant l’explication officielle et communément admise.” [Jérôme Fourquet] (Source)

Notez au passage l’expression “LA théorie du complot”, parfois reprise par les médias, qui, en toute rigueur, ne veut strictement rien dire.

“Le parti pris retenu était de brasser large” : testons donc tout et n’importe quoi… Au moins, c’est assumé. Dommage cependant que cette méthodologie très douteuse n’ait pas été explicitée au moment de l’annonce des résultats au grand public.

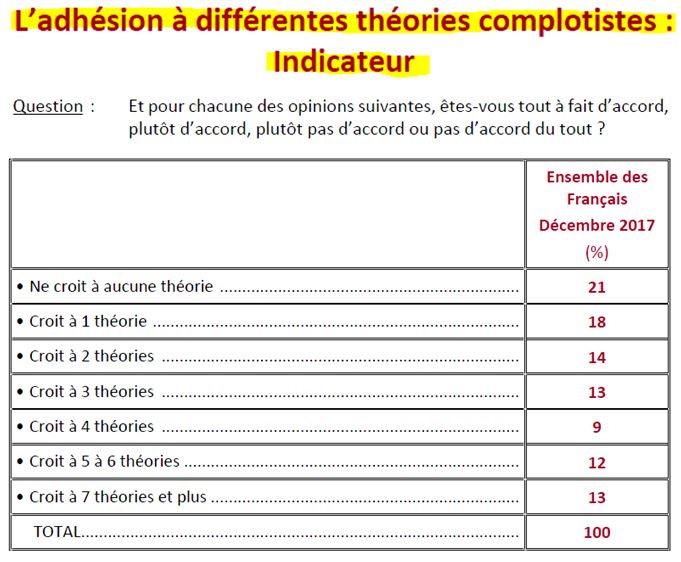

“Il ne s’agissait pas pour nous de pratiquer un quelconque amalgame” : joliment dit. Beaucoup moins joliment fait, car avant la dernière question de l’étude, le sondeur indique avoir créé un “indicateur” de l’adhésion à différentes théories complotistes :

Cet amalgame entre les réponses aux différentes théories farfelues (avec une adhésion totale comme un simple doute) est un huitième point très problématique. L’Ifop y a aussi répondu :

“La construction de l’indicateur est opaque

Afin de synthétiser les résultats de l’enquête, nous avons construit un indicateur. Cet indicateur prenait uniquement en compte les onze items testés dans la batterie principale de l’enquête (les résultats aux autres questions et notamment celle sur le rapport aux médias n’entraient pas dans la construction de cet indice). À partir de la question d’approbation à cette batterie de onze items, nous avons calculé quelle était la proportion de l’échantillon qui n’adhéraient à aucune de ces opinions, à une, à deux, à trois etc. Au total, on peut retenir la répartition suivante de la population :

- 53 % de la population n’adhèrent à aucune ou à une ou deux de ces thèses : il s’agit du public qu’on peut qualifier de « relativement hermétique » à ces différentes thèses.

- 22 % de la population adhèrent à 3 ou 4 de ces thèses : il s’agit d’un public qu’on peut considérer comme relativement perméable à ces théories.

- 25 % de la population adhèrent à 5 voire davantage de ces thèses : il s’agit d’un public potentiellement fortement réceptif à ces grilles de lecture et ces discours.” [Jérôme Fourquet] (Source)

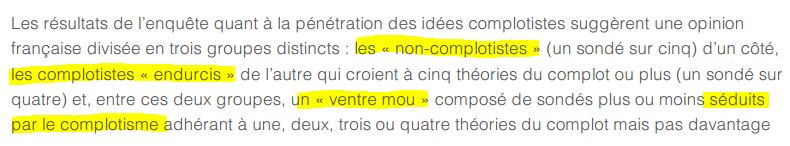

Le sondeur considère donc que les gens qui ont émis des doutes (dont il a sciemment refusé de mesurer l’intensité) sont des gens qui “adhèrent” néanmoins à ces théories, et qui sont donc, vu que c’est l’objet même de l’étude, des complotistes. D’ailleurs, dans sa note de synthèse, Rudy Reichstadt ne prend plus aucun gant (Source) :

On se demandera d’ailleurs quelles sont les bases scientifiques d’un tel regroupement, et pourquoi 3 ensembles (et pourquoi eux), et pas 2, 4, 7 ou 11…

Ce nouvel amalgame dans l’amalgame, pose, lui aussi de sérieuses questions sur l’objectif des commanditaires.

Bref, comme l’a dit précédemment l’Ifop : “Il ne s’agissait pas pour nous de pratiquer un quelconque amalgame” : qu’est-ce que cela aurait été sinon…

On comprend vite que, avec 11 questions de plus, on arriverait bien à “95 % de Français qui croient à une théorie du complot”. C’est un indicateur ridicule, qui montre qu’aucun scientifique sérieux n’a probablement validé cette méthodologie très douteuse.

Neuvième point problématique : ce lourd sondage n’a pas prévu de questions pour l’étalonner. Au vu de certaines réponses très surprenantes, voire non cohérentes, on peut douter du sérieux des réponses des sondés face à des questions ridicules. Il aurait donc été plus qu’intéressant de vérifier ce point, par exemple avec des “fausses théories du complot” inventées pour l’occasion. Par exemple : “Avez-vous déjà entendu parler de l’affirmation : “La CIA est impliquée dans la mort de l’ancien Président soviétique Leonid Brejnev” et son taux d’adhésion. Ainsi que des affirmations délirantes du genre “Une race de reptiliens venus de l’espace contrôle secrètement la plupart des dirigeants politiques de la planète”.

Dixième point problématique : il n’y a pas de question testant de vrais complots, pour tester en parallèle le degré d’esprit critique des sondés. Il est bien que des personnes ne croient pas à de faux complots, mais il serait très gênant qu’elles ne croient pas non plus à de vrais complots… Il aurait donc été intéressant de tester des questions telles que “Le gouvernement Bush a sciemment trompé les Américains en tentant de faire croire à un lien entre Saddam Hussein et les attentats du 11 Septembre”, “La CIA a renversé le Premier Ministre Iranien Mossadegh en 1953”, “L’industrie du tabac a sciemment modifié les cigarettes afin de rendre les fumeurs le plus accros possible” (Source), “Le gouvernement français a sciemment laissé distribuer à la population des stocks de sang comportant le virus du SIDA” (Source), “La CIA a financé des opérations secrètes par de la vente de cocaïne aux États-Unis” (Source), “François Hollande a secrètement rompu l’embargo européen sur les ventes d’armes pour armer la rébellion en Syrie” (Source). Enfin, il faudrait aussi tester plus généralement la méfiance des sondés, par exemple avec “Pensez-vous que, dans certains cas, le gouvernement puisse privilégier les intérêts financiers de l’industrie pharmaceutique au détriment de l’intérêt général / de la santé humaine ?”.

Onzième point problématique : il n’y a eu aucun complot “système” de testé ; ils sont tous “anti-système”, et donc, corrélés politiquement avec des partis “anti-système” – et on rappellera que c’est une officine du Parti Socialiste qui finançait l’étude. Mais, en toute rigueur scientifique, il faudrait tester d’autres types de théories du complot, marquées politiquement mais différemment, comme par exemple : “Dominique Strauss-Kahn a-t-il été victime d’un complot visant à l’empêcher de se présenter à la Présidentielle ?”, “François Fillon a-t-il été victime d’un complot visant à l’empêcher de se présenter à la Présidentielle ?”, “Le gouvernement russe a-t-il joué un rôle décisif dans l’élection de Donald Trump / du Brexit”.

Il a beaucoup été dit par les journalistes qu’il y avait un problème de “complotisme” chez les jeunes, plus ou moins lié à Internet.

Or, nous avons vu que, si on retirait les quelques questions finales totalement ineptes, les jeunes n’étaient pas plus concernés que les plus âgés.

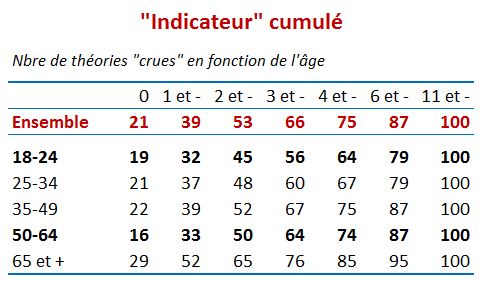

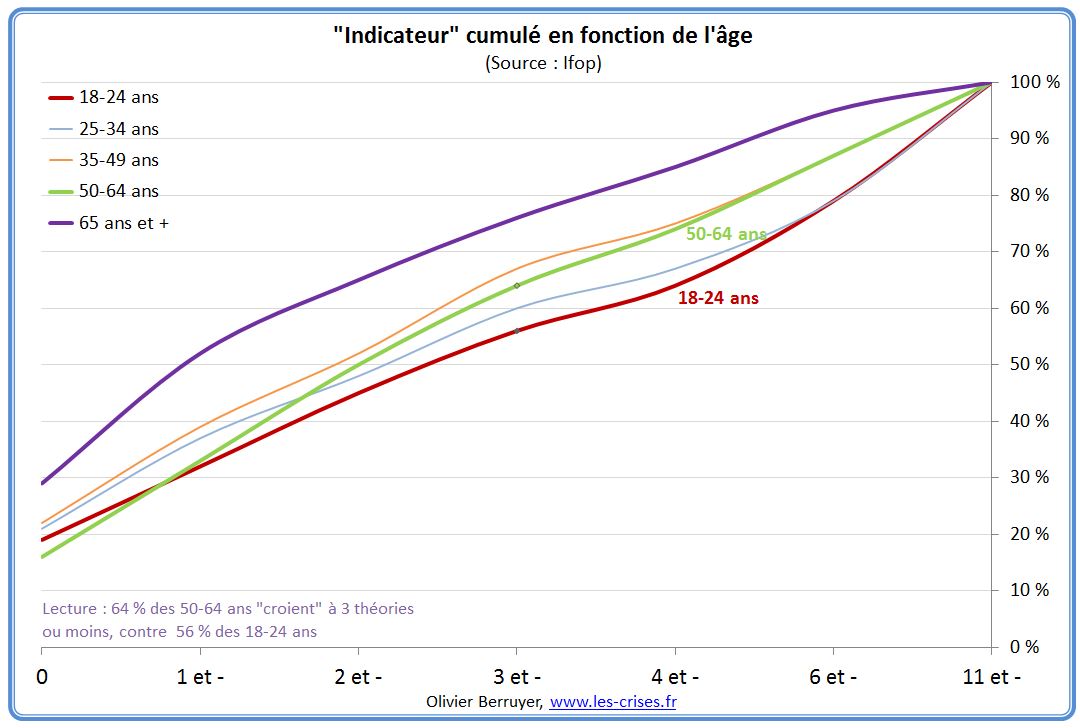

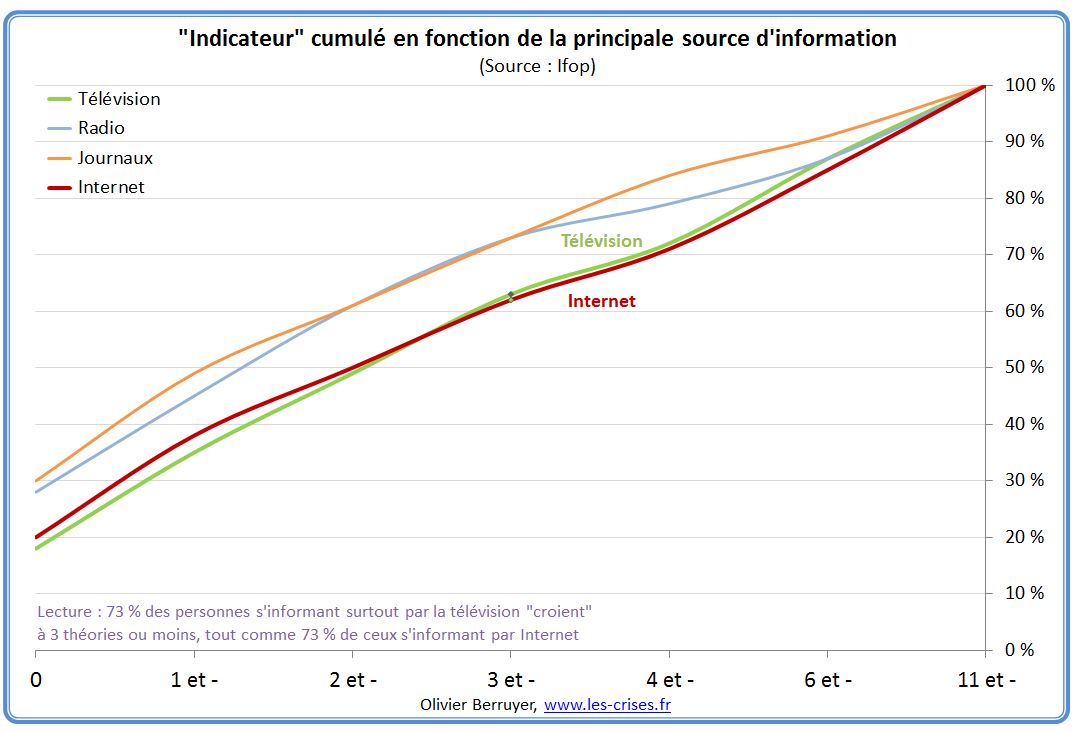

Malgré tout, en utilisant les 11 questions, et l’indicateur cumulé (qui est une aberration), on peut obtenir ces données (que le sondeur n’a étrangement pas explicité) montrant le cumul de la population qui “adhère” à 0 théories, 0 ou 1 théories, 2 théories et moins, 3 théories et moins, etc. :

Si on note, en effet, que les plus jeunes sont un peu plus nombreux à exprimer des doutes, il est clair que l’écart entre les générations de personnes de moins de 65 ans est vraiment limité – personne n’ayant même signalé que les 18-24 ans étaient plus nombreux que les 50-64 ans à ne croire à aucune théorie, démontrant bien l’existence d’un bon esprit critique chez une partie de cette génération…

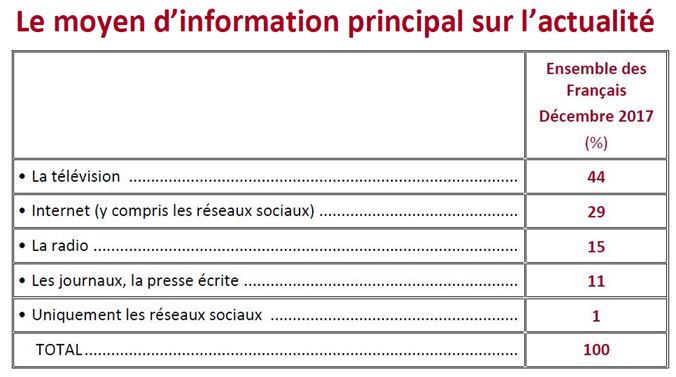

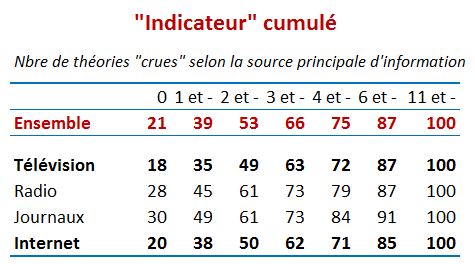

On peut faire la même chose en fonction cette fois de la source principale d’information :

On constate ici que le fait de s’informer plutôt par la télévision ou plutôt par Internet n’a aucun impact apparent sur les résultats.

La nette différence avec les personnes s’informant par la radio ou par la presse écrite s’explique probablement surtout par des différences d’âge et de niveau éducatif – plus que par l’influence du média.

III. Les autres questions

Comme on l’a vu, il y avait 12 autres questions dans l’étude. Les voici :

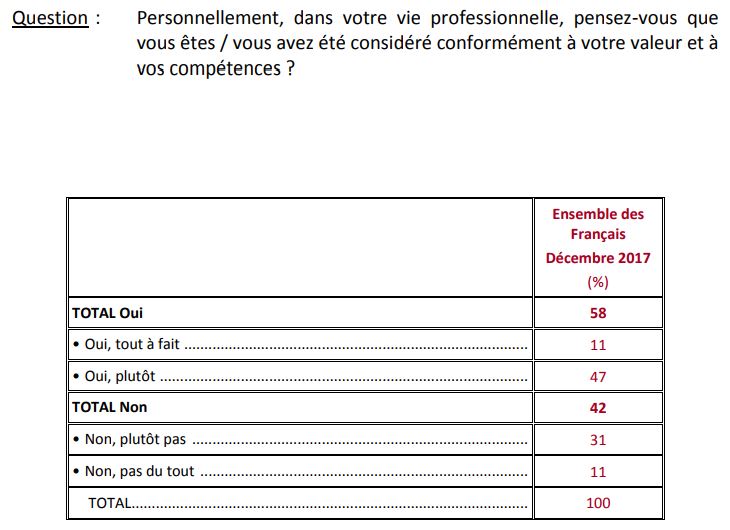

1/ Le sentiment de valorisation de soi dans sa vie professionnelle

Comme l’explique bien le journaliste Laurent Calixte, cette question était surtout faite pour mettre en confiance

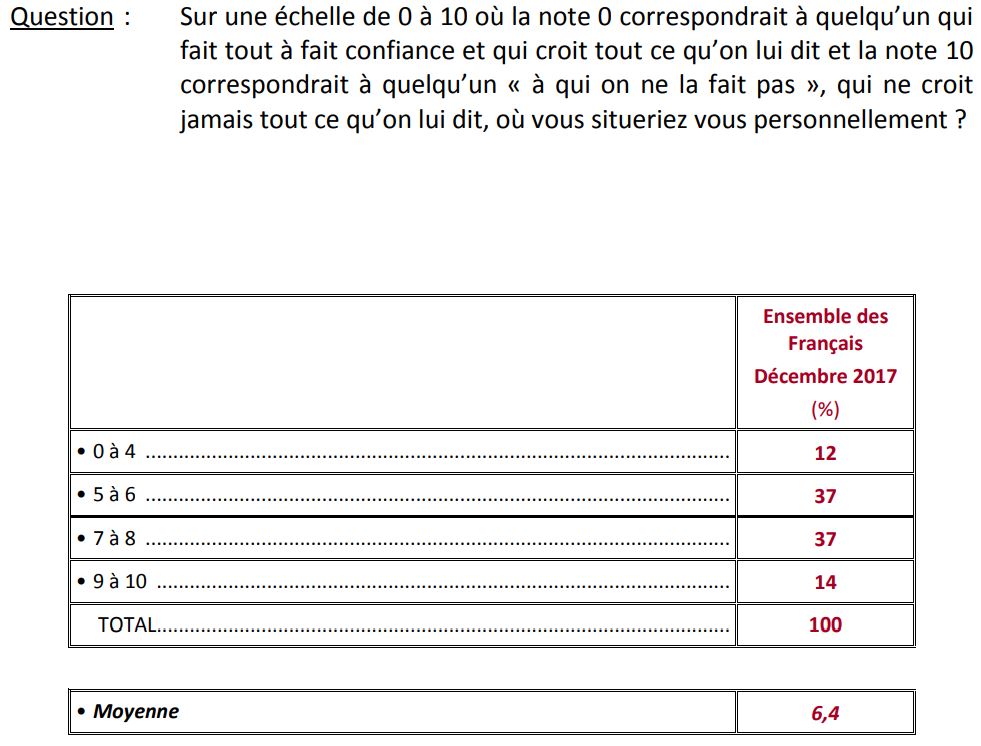

Il est intéressant d’observer l’impact politique des différences de valorisation de soi :

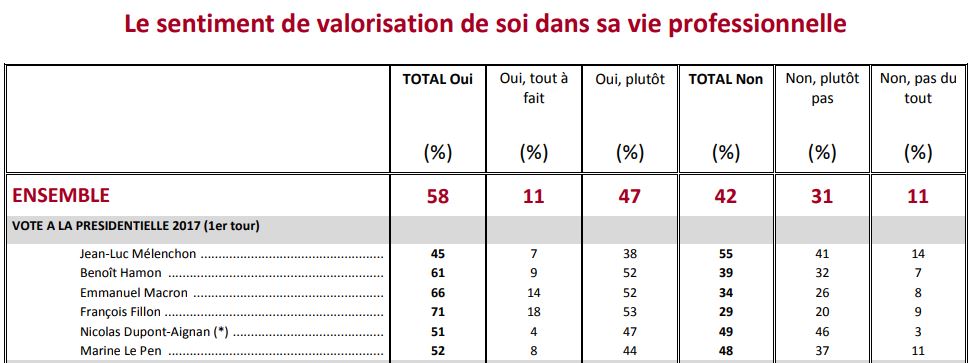

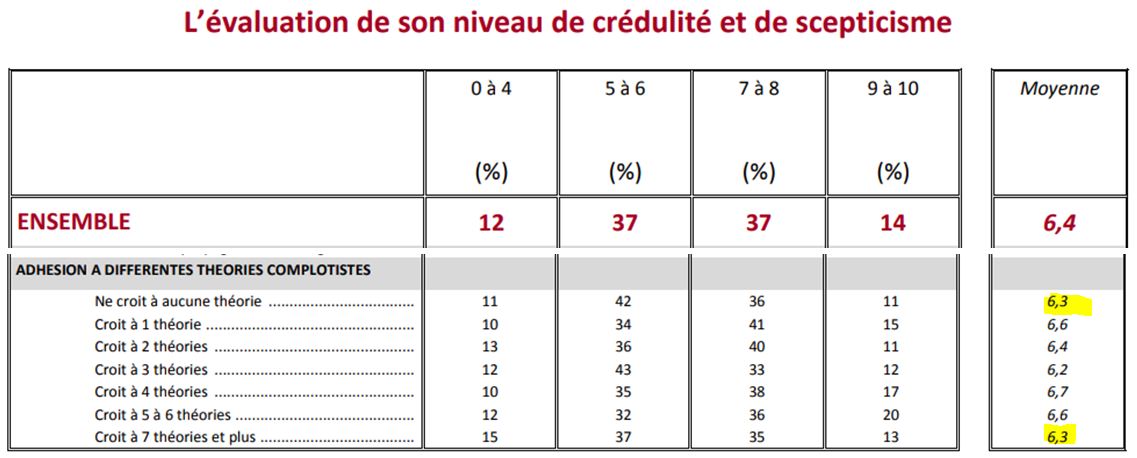

2/ L’évaluation de son niveau de crédulité et de scepticisme

Il a été demandé une autoévaluation du “niveau de crédulité et de scepticisme”

Cette question montre très bien à quel point l’étude a été très mal préparée. Car on se dit qu’à l’évidence cet indicateur ne va probablement pas être pertinent.

En effet, un individu se conformant totalement au discours médiatique se dira que, “on ne la lui fait pas” face à un discours “complotiste”.

MAIS en retour, il est évident qu’un individu classé ici comme “complotiste” se dira que, “on le la lui fait pas” face à un discours “mainstream”.

Et c’est exactement ce qui s’est passé :

Il apparaît clairement qu’il n’y a pas la moindre corrélation entre l’adhésion aux “théories complotistes” et l’autoévaluation du “niveau de crédulité et de scepticisme”…

3/ La fréquence de consultation de l’horoscope

Sans grand intérêt, si ce n’est que ça montre à quel point les concepteurs du sondage mélangent tout.

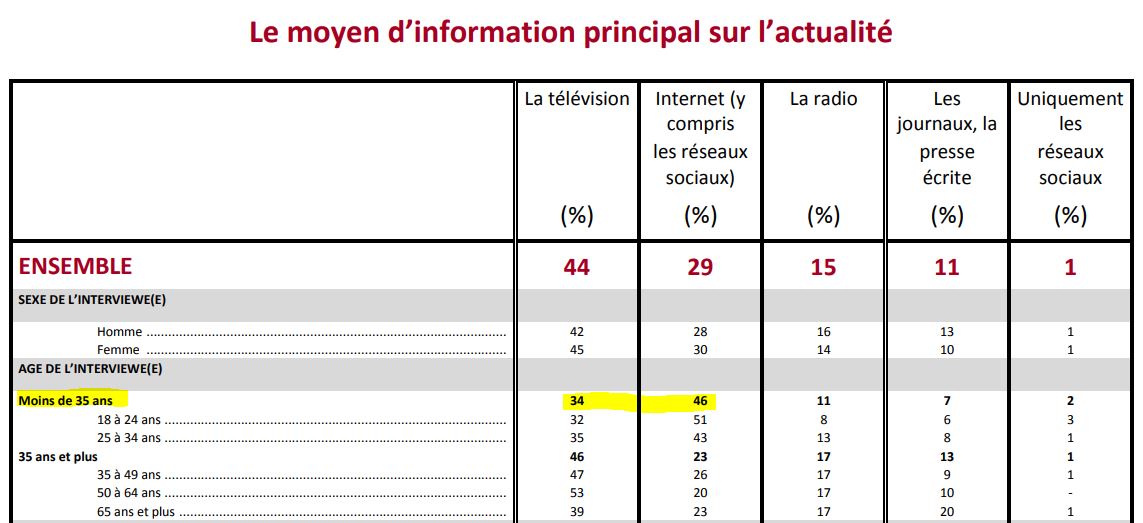

4/ Le moyen d’information principal sur l’actualité

On a montré le résultat global précédemment. Il est intéressant de regarder par âge :

On note que la télévision n’est plus le moyen d’information principal des moins de 35 ans, c’est Internet. On comprend mieux la panique qui s’empare des Pouvoirs politiques, et leur volonté de le réguler.

Notez que même chez les plus de 65 ans, le score d’Internet est loin d’être ridicule. L’avenir de la presse écrite est sombre…

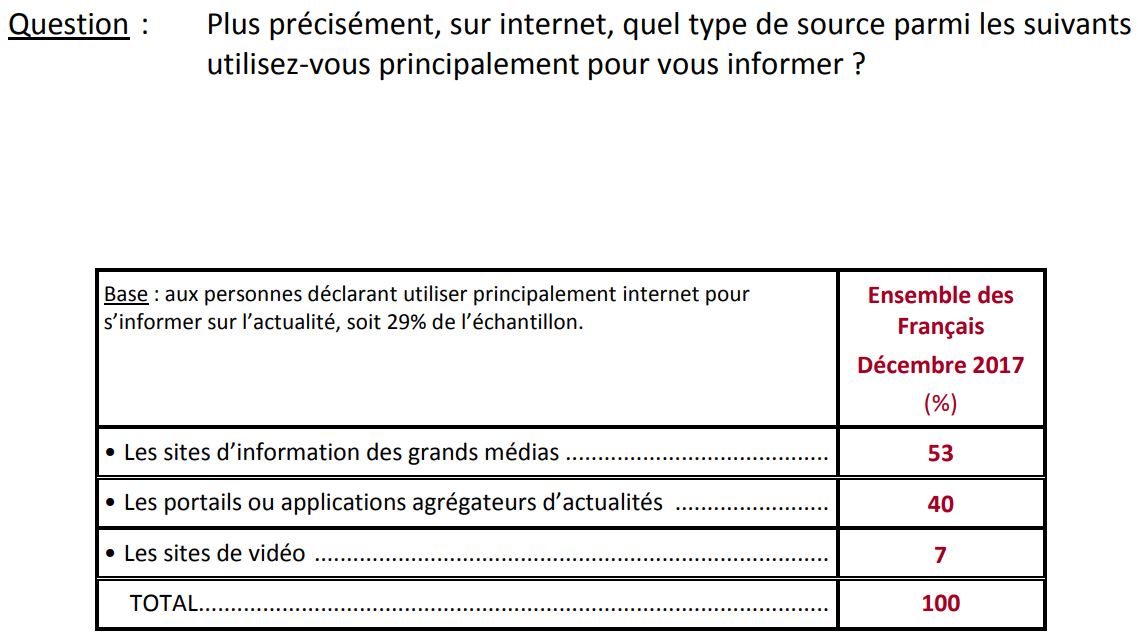

5/ Le moyen d’information en ligne principal sur l’actualité

C’est là qu’on voir, de nouveau, toute la rigueur de l’étude. Il est bien connu que, pour “s’informer sur Internet (y compris les réseaux sociaux)”, on a seulement le choix entre 1/ les sites des grands médias 2/ Les portails ou applications agrégateurs d’actualités (?) 3/ Les sites de vidéo. Les sites d’informations indépendants, les blogs, les réseaux sociaux, les forums, etc., tout ça, ça ne produit aucune information…

Du coup, les réponses sont inexploitables.

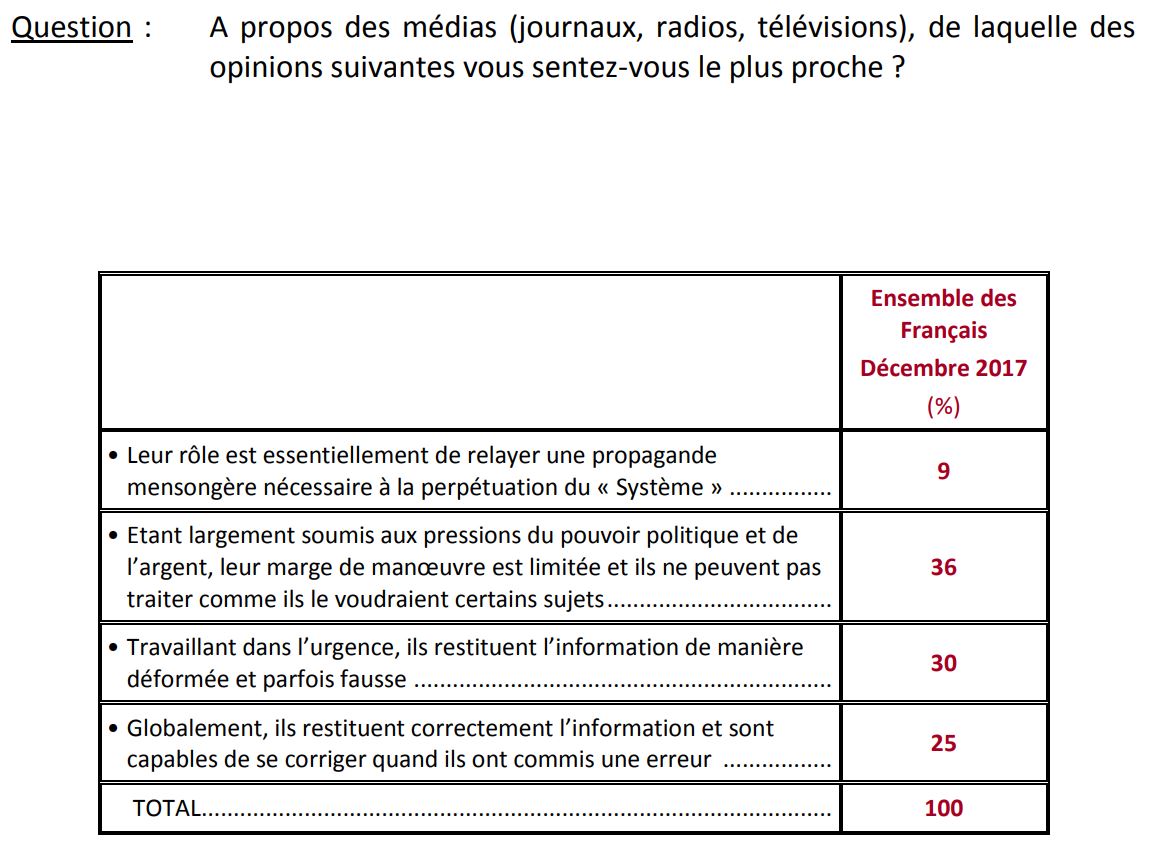

6/ Le jugement sur le niveau de compromission des médias

Encore une question mal posée. Pour le coup, ici on a affaire à des propositions non exclusives (ce n’est pas comme “1 seul tireur” ou “2 tireurs” sur Kennedy). On peut penser que les médias sont, parfois, soumis aux pressions du Pouvoir, parfois qu’ils déforment les choses car ils travaillent dans l’urgence, et parfois qu’ils travaillent bien. Cela dépend évidemment des sujets, et des médias. Il fallait tester ici les 4 questions indépendamment. Voire d’autres en plus, car on a ici 3 propositions “négatives pour les médias” et seulement une positive.

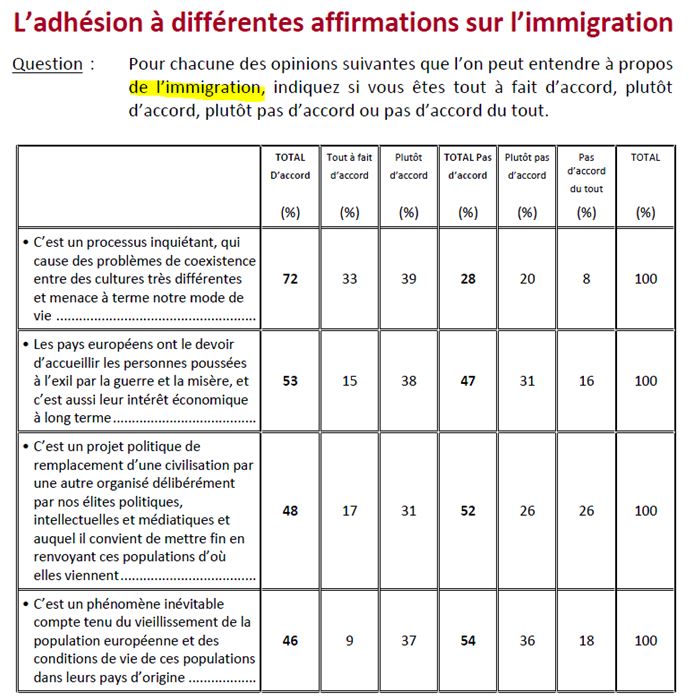

7 à 10/ L’adhésion à différentes affirmations sur l’immigration (4 questions)

Alors là encore, un bel exemple du sérieux de l’analyse. On fait une enquête sur le “complotisme” qui comporte des dizaines de questions, soit déjà beaucoup trop pour avoir un sondage fiable/ Mais le commanditaire se dit “tiens, rajoutons-en 4 sur l’immigration”. Car oui, Kennedy, les vaccins, la terre plate, l’immigration, même combat. Cela donne ceci :

Il est quand même stupéfiant qu’un sondeur ait accepté de poser, sur un sujet aussi sensible pour la Société, de telles questions “fourre-tout”. Appréciez :

1/ A/C’est un processus inquiétant,

B/ qui cause des problèmes de coexistence

C/ entre des cultures très différentes (même si les immigrés sont italiens ou anglais ?)

D/ et menace à terme notre mode de vie

2/ A/ Les pays européens

B/ ont le devoir d’accueillir les personnes

C/ poussées à l’exil par la guerre et la misère,

D/ et c’est aussi leur intérêt économique à long terme

3/ A/ C’est un projet politique

B/ de remplacement d’une civilisation par une autre

C/ organisé délibérément

D/ par nos élites politiques, intellectuelles et médiatiques

E/ et auquel il convient de mettre fin

F/ en renvoyant ces populations d’où elles viennent

4/ A/ C’est un phénomène inévitable

B/ compte tenu du vieillissement de la population européenne

C/ et des conditions de vie de ces populations dans leurs pays d’origine

Vu la masse des autres problèmes méthodologiques longuement évoqués, ces réponses sont peu exploitables.

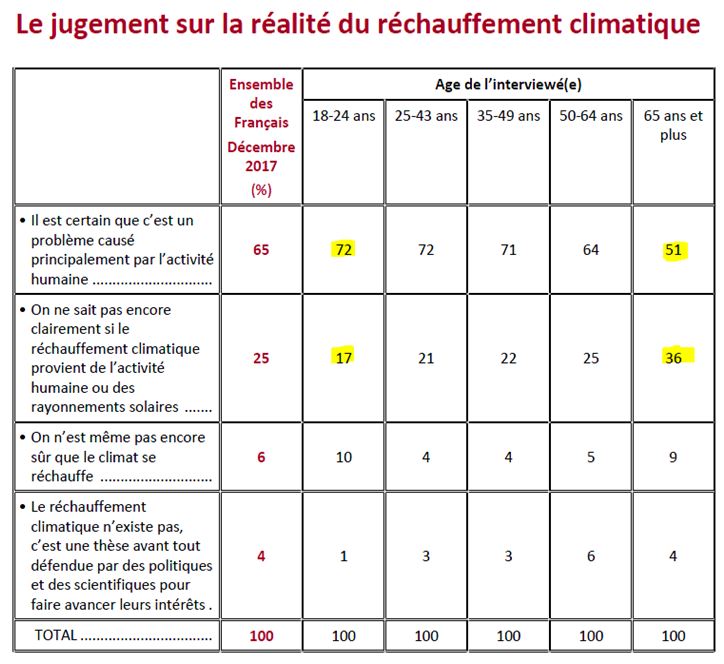

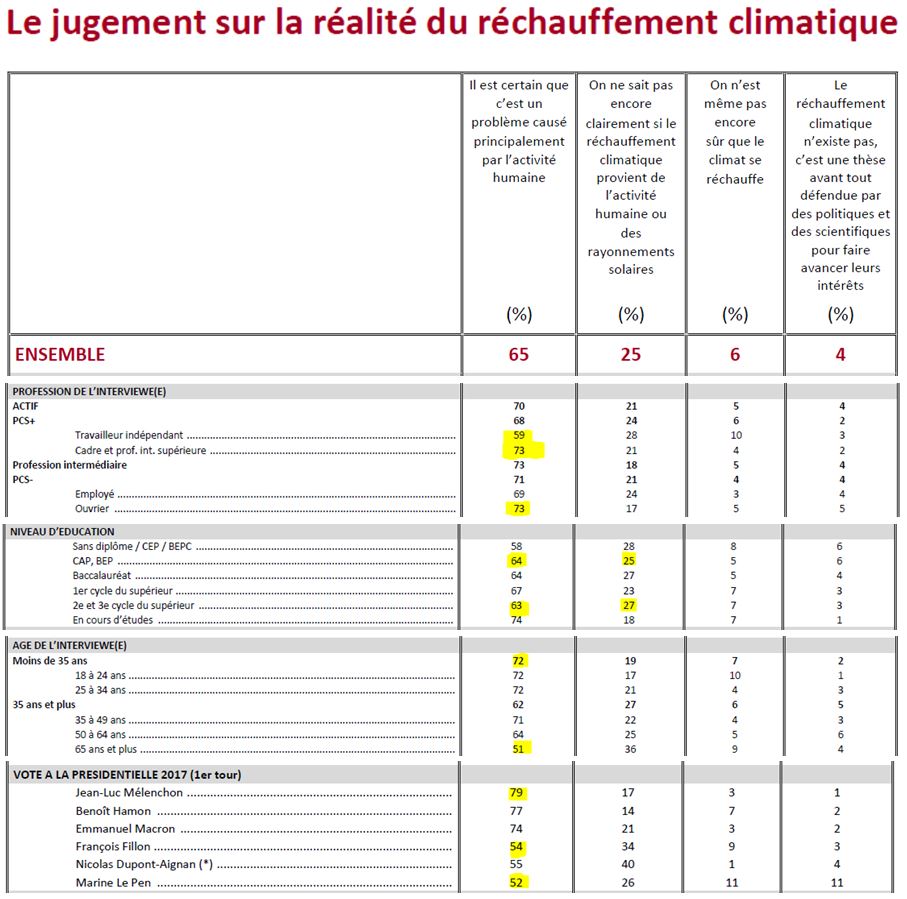

11/ Le jugement sur la réalité du réchauffement climatique

Ici, enfin, on a une question bien posée et exploitable. Et cette question est vraiment très intéressante à analyser :

Notons d’abord un problème méthodologique : on a ici une question “positive” (la première), mais 3 “négatives” ; plus on multiplie les négatives, plus la proportion de personnes qui vont “piocher dedans” va évidemment augmenter.

On constate, bonne nouvelle, que pour 90 % des gens, la Terre se réchauffe : c’est déjà très encourageant, cela montre qu’il n’y a pas de “danger du complotisme” sur un sujet, pour le coup, politiquement majeur. Certes, beaucoup trop de personnes pensent que l’homme n’y est peut-être pour rien ; il est intéressant de détailler ce point :

On note sur cette question de vraies singularités :

- les cadres et les ouvriers donnent la même proportion de bonne réponse, tout comme les titulaires de CAP et d’un 3e cycle universitaire… ;

- la catégorie adhérant le moins à la bonne réponse est celle des travailleurs indépendants ;

- les moins de 35 ans sont les mieux “informés” et ceux plus de 65 ans sont le moins “informés” ;

- les électeurs de Jean-Luc Mélenchon sont les mieux “informés” et ceux de Marine Le Pen mais aussi ceux de François Fillon sont le moins “informés”.

Cependant, ce qui précède montre qu’il est abusif de parler “d’information” ; car ici, les écarts ne s’expliquent pas par l’ignorance. Les connaisseurs de ce sujet savent qu’une fraction de la population refuse de croire ce qu’affirment l’écrasante majorité des climatologues, car ces personnes ne peuvent accepter l’idée que l’Homme puisse avoir une telle influence sur son immense Planète, que le capitalisme peut l’abîmer considérablement, que la croissance ne peut être éternelle. Et il y a dans cette catégorie une surreprésentation de seniors et de personnes de droite, indépendamment de leur niveau d’étude.

Mais là encore, ces points très importants ont à peine été soulevés – peut-être car ils ne cadraient pas avec les objectifs et le discours des commanditaires de l’étude…

En conclusion, nous vous renvoyons vers ce court billet permettant de vérifier les ordres de grandeur du réchauffement planétaire, par un calcul très simple…

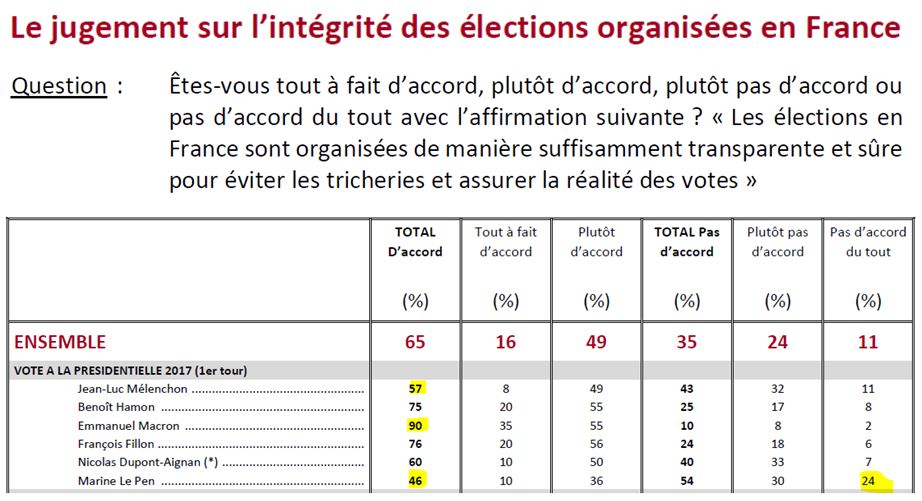

12/ Le jugement sur l’intégrité des élections organisées en France

Ici la question est de nouveau ambiguë : « Les élections en France sont organisées de manière suffisamment transparente et sûre pour éviter les tricheries et assurer la réalité des votes »

Il semble bien que la question porte sur les opérations physiques de vote, le jour du scrutin.

Mais parler simplement de “l’organisation en France des élections” peut aussi laisser penser à certains sondés qu’on parle du processus global des élections, comme par exemple de la campagne électorale, du financement ou du rôle de la presse.

Le résultat montre une part élevée de défiance sur l’honnêteté des élections chez les électeurs du Front National – mais cela pourrait tout autant être l’expression d’une défiance en réaction au traitement médiatique de leur candidate durant les campagnes électorales.

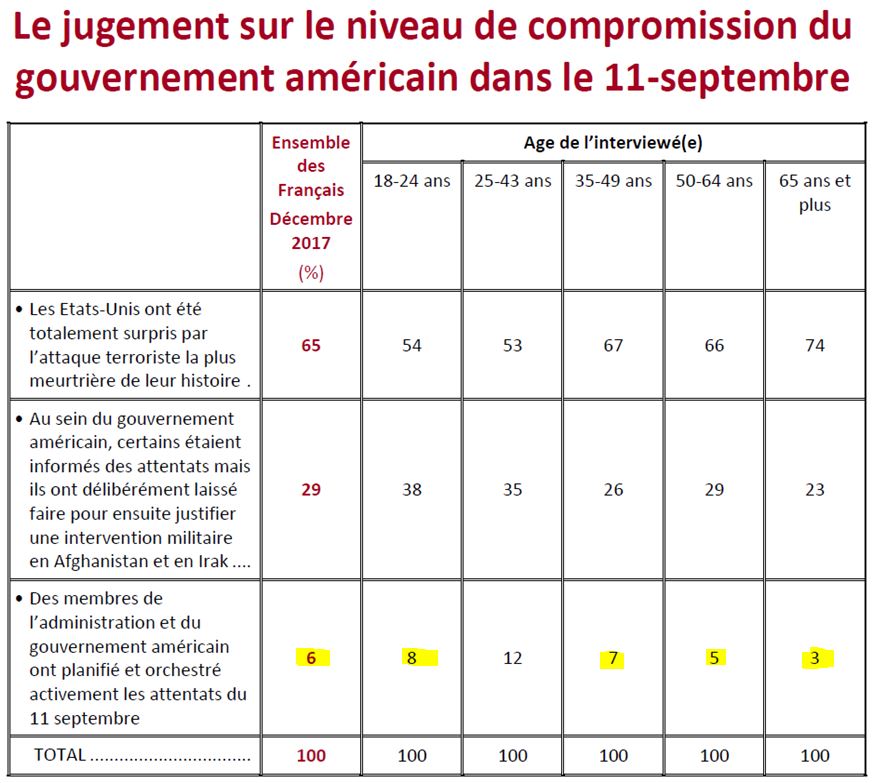

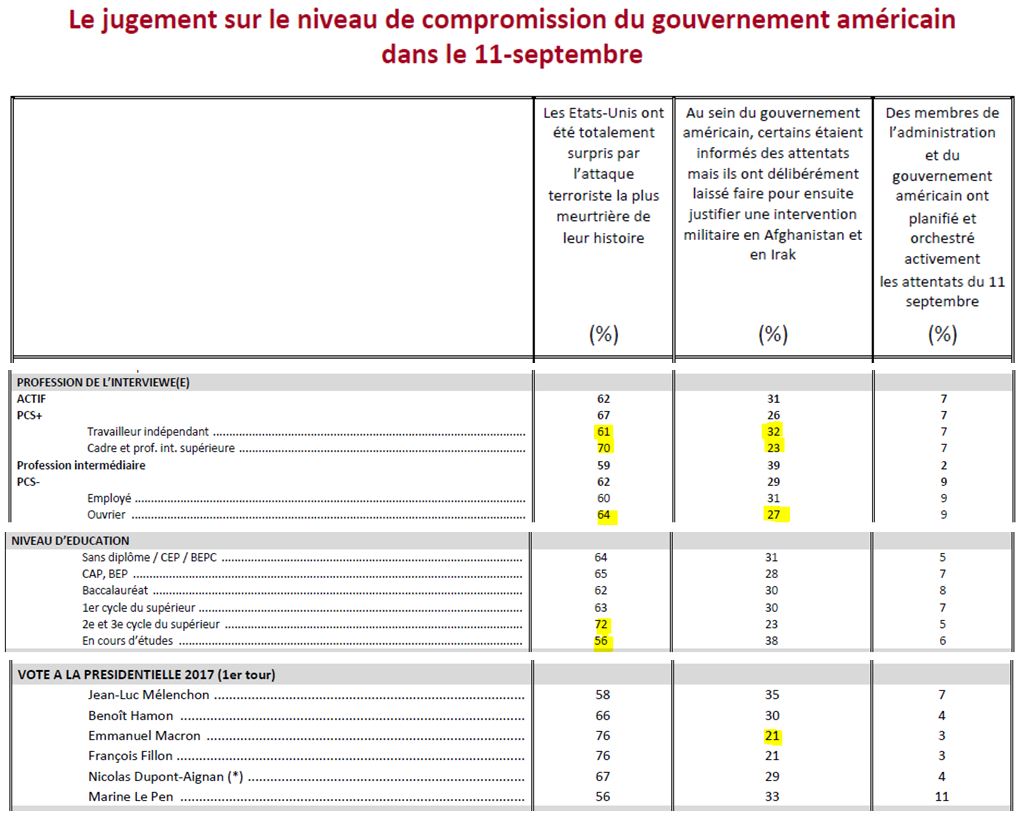

13/ Le jugement sur le niveau de compromission du gouvernement américain dans le 11-Septembre

Nous avons ensuite un sondage sur le 11 Septembre qui est très intéressant. Les questions ont été bien posées : les sondés doivent choisir une des trois propositions, et celles-ci sont claires et peu ambiguës :

Bilan : le terrible “complotisme” du 11 Septembre a en réalité une adhésion très limitée, seuls 6 % des sondés ont pris l’option véritablement, “complotiste”, soit moins que pour “la Terre est plate” ou “on n’a jamais marché sur la lune”… Sur ce point l’influence de l’âge n’est guère significative – bref, une belle occasion de perdue pour incriminer les jeunes…

Les chiffres détaillés montrent un gros bloc moyen, avec des très éduqués moins crédules, et des étudiants un peu plus crédules.

Ainsi, il y a aussi quelques écarts en fonction de l’orientation politique, mais on notera que les macronistes sont quand même 20 % à avoir des doutes sur l’intégrité du gouvernement Bush…

Bien sûr, on pourra regretter qu’il reste une importante masse de personnes qui pensent que les dirigeants sont des maniaques prêts à tuer ou laisser tuer leur propre population en masse – ce qui n’est pas réaliste. Mais il est probablement impossible de réduire ce nombre pour plusieurs raisons.

La première est que les dirigeants ont généralement une indifférence totale pour les populations étrangères, qu’ils voient comme des “non-personnes”. Citons par exemple cette vidéo de la Secrétaire d’État de Bill Clinton, Madeleine Albright :

Et cette indifférence aux étrangers lointains laisse penser à certains que ces dirigeants considèrent aussi leur propre population comme des non-personnes (raisonnement intellectuellement cohérent, mais faux en pratique). Disposer de dirigeants agissant en permanence suivant des critères moraux respectables permettrait de limiter de telles craintes.

Deuxièmement, en pratique, un peu avant le 11 Septembre, il est vrai qu’il y a eu des alertes réelles qui auraient dû entraîner plus de réactions des services de sécurité. Ces grosses défaillances, qui semblent parfois incompréhensibles (comme nous l’avons montré ici) ont tendance chez certaines personnes à induire un soupçon de complicité, ces gens préférant penser qu’ils ont affaire à des génies de la manipulation, plutôt qu’à d’énormes incompétents. Ce billet fournit une explication de la “surdité” du gouvernement Bush à ces alertes – qui nous semble être probablement assez proche de la vérité.

Troisièmement, ces dirigeants incompétents, quand ils constatent la survenance du drame, ont la plupart du temps tendance à mentir, pour cacher leurs erreurs et manquements. Et les médias enquêtent généralement bien peu sur ce point. Quand certaines personnes fouillent et découvrent ces mensonges, cela occasionne de nouveau un fort soupçon de complicité dans le drame, alors que ces dirigeants cachent simplement leurs erreurs. Leur mentalité est d’ailleurs rarement de sanctionner les fonctionnaires coupables d’erreurs, car les ministres étant in fine les chefs, cela reviendrait à reconnaitre qu’ils auraient alors une part de responsabilité indirecte dans le drame – et pourraient donc être poussés à démissionner. C’est par exemple pourquoi le capitaine de l’UUS Cole qui a abattu par erreur l’avion civil Iranien du vol 655 en 1988 a été promu, ou que Bernard Cazeneuve a pu rester ministre de l’Intérieur pendant la succession d’attentats en 2015-2016 (avant d’être promu Premier Ministre…).

D’autant que les gens raisonnent généralement un peu « à l’envers ». Il faut bien se dire que, quand survient un gros attentat, c’est que, FORCÉMENT, il y a eu des erreurs. Puisque le travail des forces de sécurité est de les éviter – ce qu’ils font très régulièrement. Donc si on creuse, on trouvera forcément plusieurs occasions où auraient pu être empêchés les attentats de Charlie Hebdo, du Bataclan, ou de Nice. L’objectif du Pouvoir sera alors de cacher ou de minimiser ces erreurs, et de présenter l’attentat comme inévitable, ce qui est souvent très discutable. On l’a encore vu très récemment pour celui de Saint Étienne du Rouvray. Difficulté supplémentaire, il n’y aura évidemment jamais de preuve attestant que ces erreurs n’étaient pas volontaires, ni qu’elles l’étaient ; le doute sera donc impossible à lever définitivement.

Mais à ce stade rappelons bien que ces éléments ne peuvent pas aboutir à l’équation : “attentat = gouvernement”. Répétons clairement que, bien évidemment, les gouvernements et les forces de l’ordre font de leur mieux pour empêcher ce genre de tragédie, mais il n’empêche que la complexité des situations rend parfois possible la commission de certaines erreurs.

Enfin, plus les médias mainstream sortiront de leur rôle visant à transmettre de l’information, pour plutôt occuper une place de « militants » (le plus souvent, conformément aux vues du Pouvoir), plus les doutes de certaines personnes seront renforcés.

Pour en revenir au 11 Septembre, l’absence générale de comportement moral conjugué au manque involontaire d’écoute des alertes (en raison de son incompétence) qui a permis aux attentats de réussir, puis les mensonges utilisés pour cacher ses erreurs, font que le gouvernement Bush a évidemment suscité une très forte défiance d’une partie de la population, qui le croit donc capable du pire, même contre sa propre population.

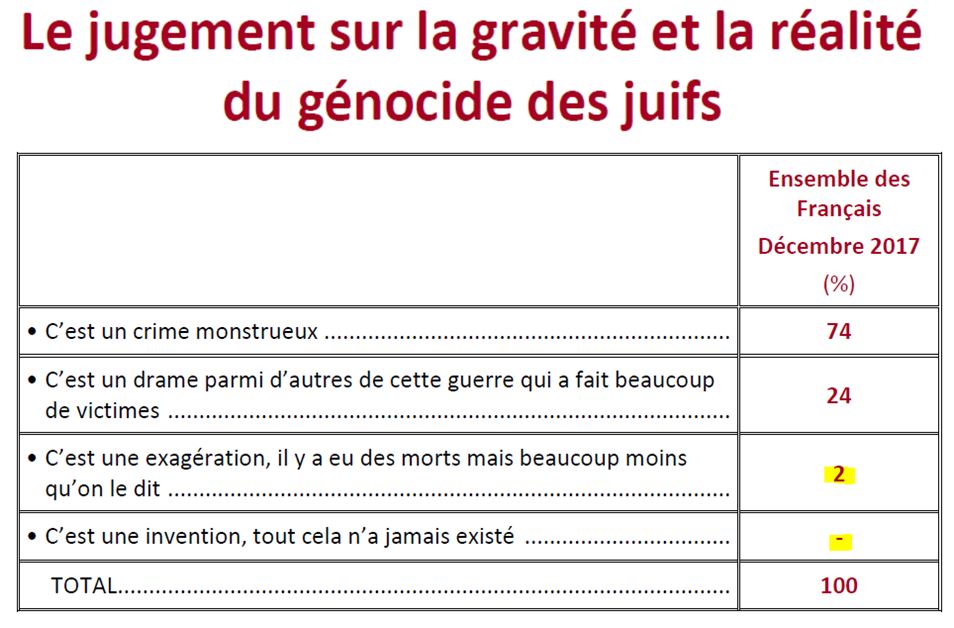

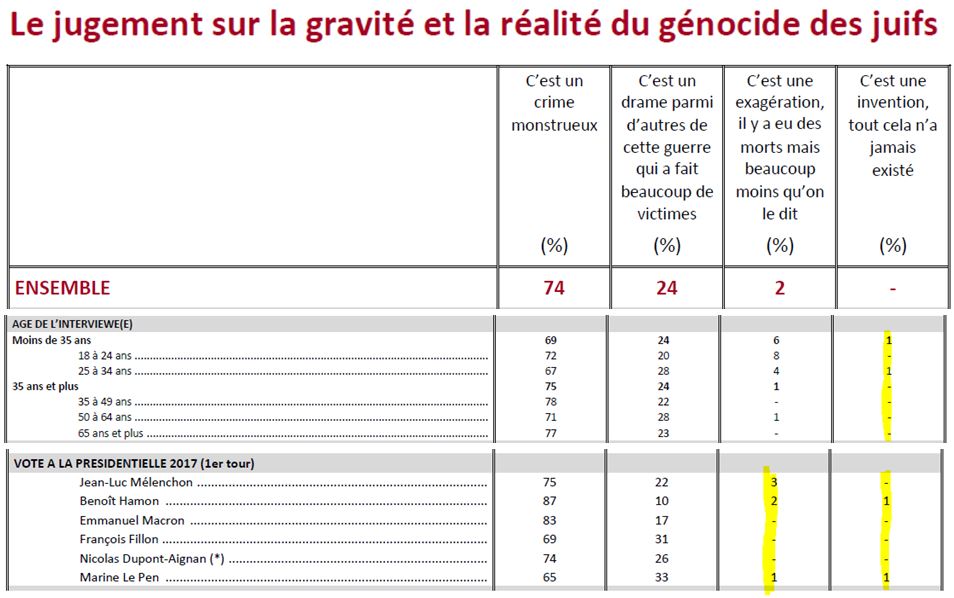

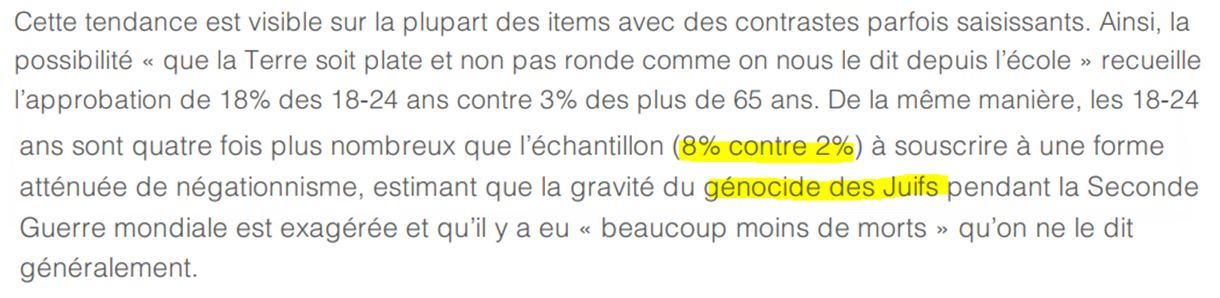

14/ Le jugement sur la gravité et la réalité du génocide des juifs

Se glisse au milieu de l’étude une question très importante sur le révisionnisme :

Réponse : AUCUN révisionniste déclaré, 2 % qui considèrent que c’est une « exagération ». C’est la marge d’erreur. D’après ce sondage, on constate donc que le phénomène est heureusement très limité – ce qui est une excellente nouvelle.

Mais comme l’a indiqué Arrêts sur Images : “Mais l’étude apportait aussi une bonne nouvelle, curieusement passée sous silence. Les personnes interrogées devaient aussi répondre à une question sur le génocide des Juifs pendant la Seconde guerre mondiale. Parmi elles, 0% a répondu qu’il s’agissait d’une invention. Voilà au moins une théorie du complot qui semble avoir fait son temps.”

Le détail donne la même chose :

Rudy Reichstadt s’est rattrapé aux branches avec les “8 %” disons “d’exagérateurs” chez les 18-24 ans, mais sachant que la marge d’erreur est d’environ 4 à 5 points sur cette catégorie, cet argument semble bien peu sérieux.

Nous ne développons pas plus, car il faut en fait lier cette question avec la suivante – et dernière de l’enquête.

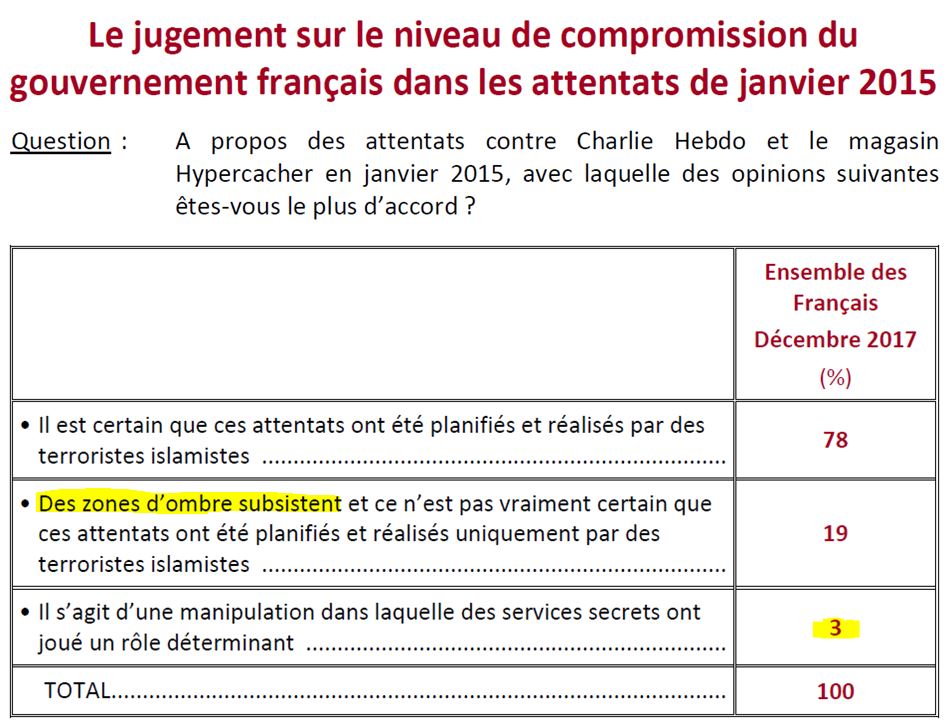

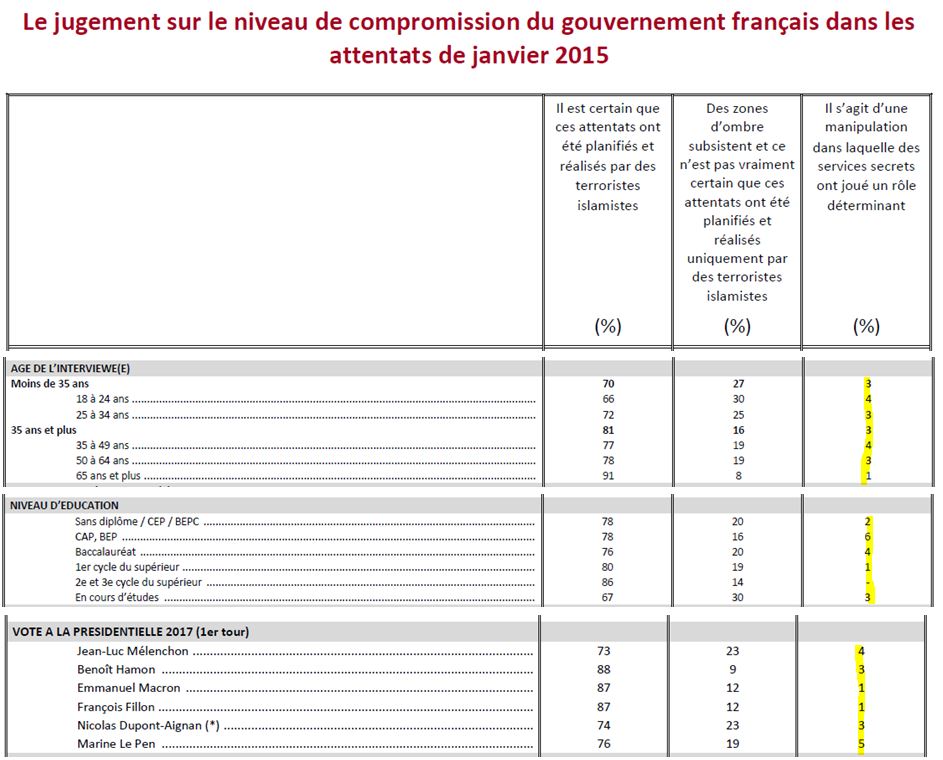

37/ Le jugement sur le niveau de compromission du gouvernement français dans les attentats de janvier 2015

Cet énorme sondage a été réalisé, comme l’a indiqué Rudy Reichstadt, à l’occasion des 3 ans des attentats de janvier 2015, dont on se rappelle qu’ils avaient été marqués sur le moment par un fleurissement sur Internet de théories délirantes. Bilan 3 ans après :

On notera que la question est, encore, inexploitable, certaines réponses testant deux items :

A/ Des zones d’ombre subsistent

B/ et il n’est pas vraiment certain que ces attentats ont été planifiés et réalisés uniquement par des terroristes islamistes

Notons que le premier point est un truisme : il est évident que beaucoup de sondés vont considérer que, comme souvent “des zones d’ombres subsistent”, sans forcément penser le moins du monde à “un complot”, mais juste à des erreurs plus ou moins sanctionnées (par exemple sur les failles béantes de la sécurité du journal en 2015).

Là encore, on observe clairement que le vrai complotisme, endurci, est en réalité un phénomène totalement marginal, à la limite même des marges d’erreurs…

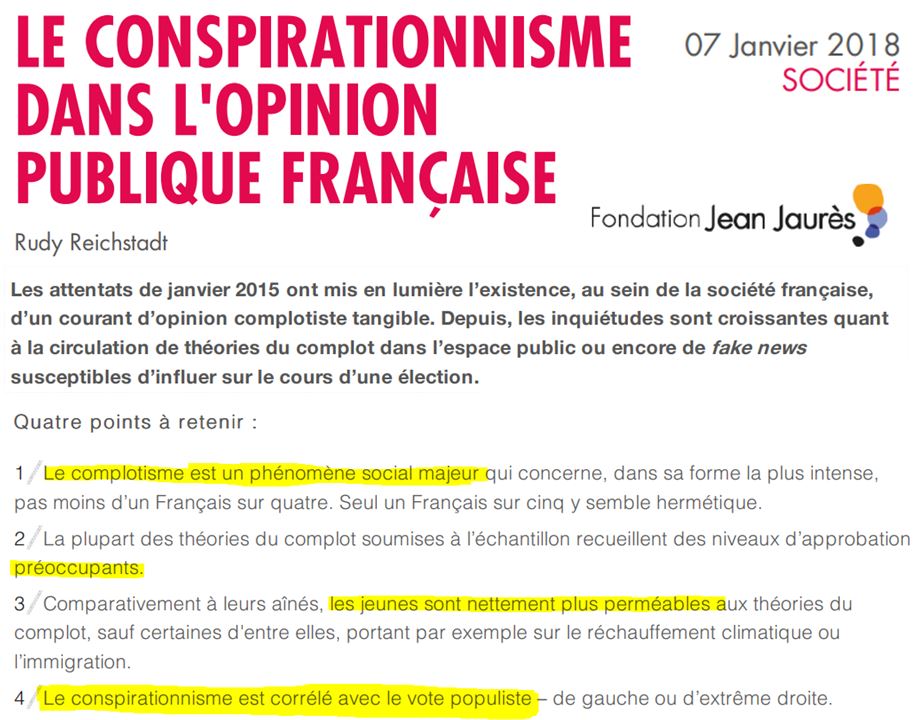

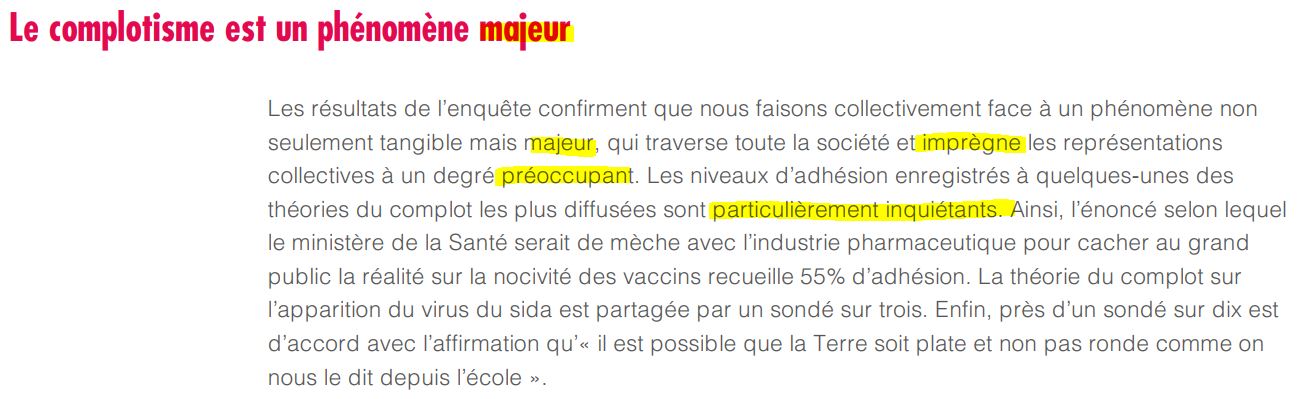

III. L’analyse de Conspiracy Watch

Observons maintenant l’analyse qu’a réalisée Rudy Reichstadt, pour le compte de la Fondation Jean Jaurès, de ce sondage. Elle est disponible ici (source.), et nous en retenons les points suivants :

On note les incohérences par rapport au fond de l’étude, et en particulier le ton très alarmiste, la “mise en accusation” des jeunes, et l’utilisation politique du sondage…

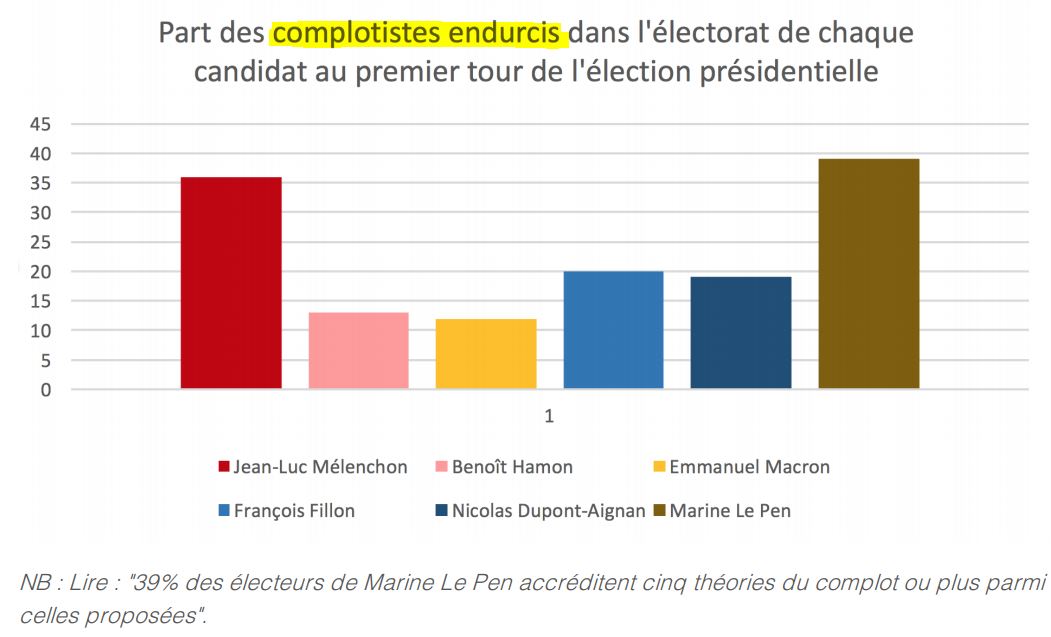

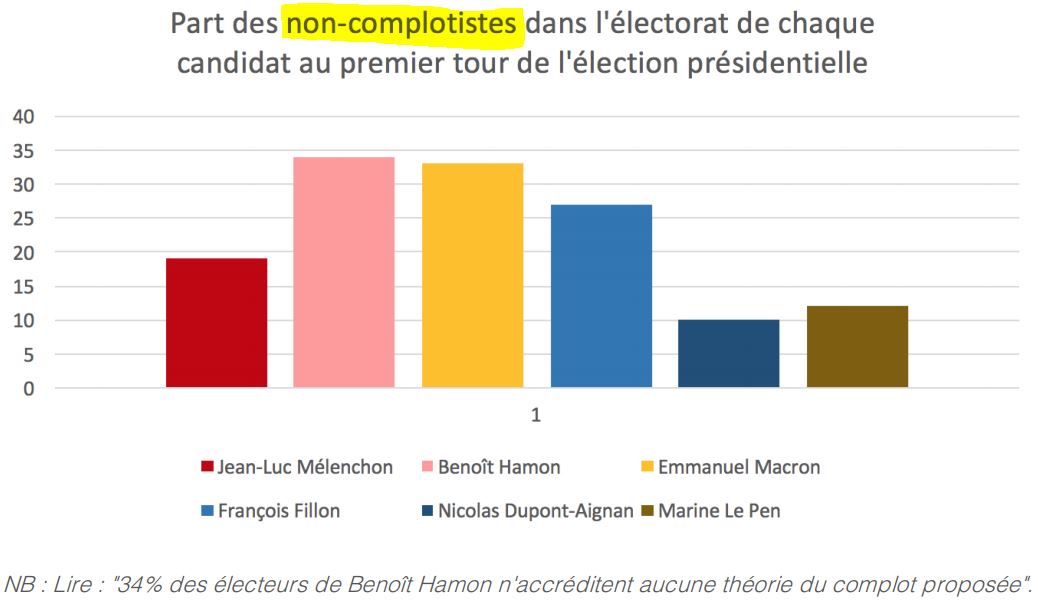

On a dans ce passage un intéressant résumé de la pensée des auteurs :

Le problème est bien le résultat des élections en Angleterre et aux États-Unis qui a déplu à cette officine du PS, et qu’ils attribuent donc, sans preuve, à des “fake news”. Attitude que, certains auteurs, ont par ailleurs qualifiée de “conspirationniste”…

Et là encore, on note que seules quelques fausses informations sont visées, pas d’autres (Source) :

Soulignons de nouveau l’un des principaux buts du sondage : son utilisation politique.

On notera tout particulièrement cette phrase : “le conspirationnisme est corrélé…” qui semble laisser penser qu’on parlerait d’une sorte de “maladie” précisément définie, alors que, bien évidemment, il n’y a pas de définition précise en l’espèce, et qu’on aurait une tout autre corrélation en posant des questions orientées différemment – par exemple en lien avec un “complot” de la Russie…

On remarque également, le fait que la note n’évoque à aucun moment clairement le fait que le négationnisme obtient des scores extrêmement faibles – on a simplement ceci :

Enfin, sans surprise de la part de Conspiracy Watch, on a de nouveau de la pub pour un des auteurs phares du très douteux site Dreuz (Sources : ici et là) :

IV. La réception par les spécialistes

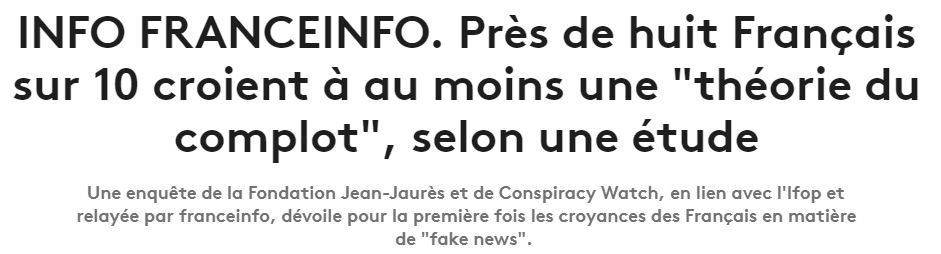

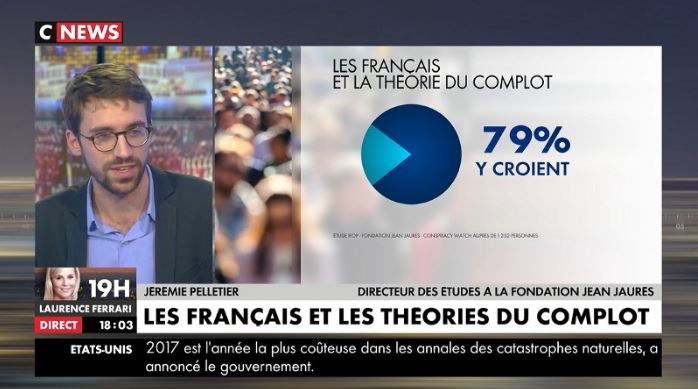

Quelques médias ont bien imprudemment repris ces “informations” sans les vérifier, tentant d’affoler la population (Sources : ici et là) :

“les résultats de l’étude sur le complotisme publiés dimanche 7 janvier par la Fondation Jean-Jaurès et Conspiracy Watch, font froid dans le dos.”

Évidemment, face à tant de problèmes méthodologiques, les analystes compétents n’ont pas manqué de décrier cette étude.

On saluera le journaliste Hadrien Mathoux de Marianne qui a été le premier à soulever le gros problème dès le lendemain de la publication :

“Huit Français sur 10 complotistes” : pourquoi ce sondage est problématique

A y regarder de plus près, la manière dont a été construite cette étude recèle plusieurs éléments problématiques qui atténuent sa portée. […]

Certaines de ces théories n’étaient justement pas toujours connues des sondés avant l’enquête. Or, celle-ci ne fait pas la différence entre ceux qui les connaissaient et ceux qui les ont découvertes avec la question. […] “C’est embêtant, sachant qu’une bonne partie des gens découvrent les théories en question, d’annoncer des résultats auprès de l’ensemble des Français, regrette pour Marianne Mathieu Gallard, sondeur à l’institut Ipsos. Cela n’a pas la même portée que de poser la question auprès des gens qui connaissaient ces théories au préalable, qui ont réfléchi dessus”. En clair, l’étude mélange des complotistes éprouvés, qui nourrissent des théories plus ou moins absurdes, et de simples sondés qui ont pu se dire “plutôt d’accord” avec l’une de ces thèses quand celle-ci leur est soumise. “Si 8 Français sur 10 ne sont sans doute pas complotistes, ils peuvent être sensibles à des idées qui ont trait au complotisme”, résume Mathieu Gallard.

Le gloubi-boulga des questions posées : Autre élément frappant à la lecture complète du sondage : les intitulés des questions, plus ou moins précis voire orientés […]

Mathieu Gallard, d’Ipsos, estime qu’il était “intéressant d’avoir une graduation de théories complotistes” mais reconnaît que certaines de celles-ci “contiennent des éléments qui posent question”. […]

Autre limite méthodologique préoccupante : l’Ifop indique que “les sondés ne se sont pas vu proposer de réponse ‘je ne me prononce pas'”. Seules deux possibilités sont donc offertes : on croit à une théorie, ou on n’y croit pas. “On oblige à se positionner sur une version ‘officielle’ et une version complotiste, alors que le sondé ne connaît pas le sujet !”, relève le journaliste scientifique Martin Clavey, très critique vis-à-vis de l’étude. Le but, selon lui, est de classer au chausse-pied chaque sondé “dans le cas des gentils qui n’y croient pas, ou dans celui des méchants qui y croient. Cela polarise artificiellement la société”. […] Avec un râteau aussi large, facile de parvenir à 79% de Français complotistes ! […]

Conclusion : quand on leur pose une question précise sur un événement qu’ils connaissent bien et sur lequel ils ont été informés en direct par la presse, les Français se montrent beaucoup moins “complotistes” que sur la révolution bolchévique ou l’assassinat de JFK.

Bien plus sévère encore, l’Observatoire des Sondages, dont c’est l’objet, a même du publier deux articles pour démonter ce sondage :

Complotisme : fake news à la une (partie I) et partie II

l’Observatoire ne se faisait guère d’illusion sur la qualité de cette publication. Les premiers comptes-rendus de la presse avec leurs titrailles sensationnalistes publiés avant sa parution officielle confirmaient ces doutes [2]. De fait celle-ci est particulièrement calamiteuse.[…]

Confusionnisme : Plus le questionnaire avance plus l’objet de l’enquête devient flou, les auteurs semblant maîtriser avec difficulté la définition même du terme complotisme. C’est fâcheux. […]

Le classement dans la catégorie « Fake news » s’impose (presque) de lui même. […]

De telles incohérences et disparités de traitement affectent bien évidemment les résultats. Leur ampleur pourrait surprendre. […]

Pratiques manipulatoires : un peu, beaucoup, passionnément ? […]

Des conclusions qui ont fait le bonheur de la presse, confirmant sa perméabilité aux fake news. […]

La presse n’a-t-elle vraiment rien vu ? C’est probable. On sait que le recrutement des journalistes professionnels ne s’effectuent pas sur leurs compétences en sciences sociales, et que les sensibilités à la critique scientifique de la doxosophie constitue même un handicap dans le métier tant sondeurs et médias sont entremêlés. Et cette fake news sur le complotisme n’indique rien de bon.

La journaliste Hélène Assekour du Site arrêt sur Images a également fait un bon travail d’information :

THÉORIES DU COMPLOT : LES MÉDIAS S’EMBALLENT

DE NOMBREUX BIAIS MÉTHODOLOGIQUES

Notons à ce sujet qu’il s’agit d’un sondage auto-administré, sur Internet. Les personnes interrogées avaient donc un questionnaire à remplir elles-mêmes, seules devant leur écran, sans avoir la possibilité de demander des éclaircissements à un enquêteur. […]

Autre problème méthodologique : les sondé.e.s n’avaient pas la possibilité de ne pas se prononcer. Ils devaient donc forcément donner un avis, même sur les théories dont ils n’avaient jamais entendu parler auparavant. Ajoutons le fait que les questions portaient sur des domaines très variées, de la réalité de l’influence humaine dans le changement climatique à la manipulation des groupes djihadistes par les services secrets occidentaux en passant par la création de la Terre par Dieu “il y a moins de 10 000 ans”. […]

Mais l’étude apportait aussi une bonne nouvelle, curieusement passée sous silence. Les personnes interrogées devaient aussi répondre à une question sur le génocide des Juifs pendant la Seconde guerre mondiale. Parmi elles, 0% a répondu qu’il s’agissait d’une invention.

Le Monde a finalement rétro-pédalé :

Théories du complot : « Croire à des bêtises, ce n’est pas être conspirationniste »

Pour l’historien Emmanuel Kreis, l’étude montrant que des Français adhèrent à des théories complotistes pose de nombreux problèmes.

Ce sondage pose pas mal de problèmes. […] Par ailleurs les théories présentées ne sont pas forcément des théories du complot, il y a un peu tout et n’importe quoi aussi. Croire à des bêtises, ce n’est pas être conspirationniste.

Sciences et Avenir a aussi donné sa vision :

Un sondage qui a ses limites

Outre le fait que les marges d’erreur, inhérentes à tout sondage, font que ces résultats sont à prendre “avec des pincettes”, l’on peut également émettre quelques réserves sur la méthodologie de l’enquête, consistant à fournir l’énoncé des théories du complot (exemple : “Les Américains ne sont jamais allés sur la lune et la NASA a fabriqué des fausses preuves et de fausses images de l’atterrissage de la mission Apollo sur la lune”) puis à demander l’approbation ou non des interrogés à ces énoncés. Les chiffres auraient probablement été différents si les théories n’avaient pas été autant suggérés par l’enquête…

La Croix interroge le spécialiste Arnaud Mercier :

Théorie du complot : « gare à la marchandisation du doute »

[Les résultats de ce sondage sont « brouillés »] Cette étude veut tester à la fois la crédulité des Français et leur scepticisme. Or ce n’est pas la même chose. La crédulité est l’aptitude à croire des choses fausses, comme : la Terre est plate. Le scepticisme est la capacité à faire preuve d’esprit critique par rapport à ce qui est présenté comme vérité officielle. Il est vrai, par exemple, qu’il reste des zones d’ombre sur l’assassinat de Kennedy. Et on ne peut pas mettre sur le même plan l’horoscope et le réchauffement climatique. Le problème méthodologique de ce sondage fait qu’il participe à ce brouillage des repères, au lieu de nous apporter quelques certitudes sur lesquelles on peut agir.

On appréciera vraiment l’article très lucide et drôle de Samuel Gontier de Télérama :

Anne-Sophie Lapix tombe dans le complot

Malgré son meilleur niveau, le nouveau “20 heures” de France 2 tombe encore dans le panneau. Lundi dernier, Anne-Sophie Lapix relaie un sondage idiot destiné à prouver que les idiots sont des idiots (complotistes).

Cependant, le meilleur article a probablement été écrit par le journaliste scientifique Laurent Callixte, que je vous recommande vivement de lire, car il présente les techniques poussant le sondé dans un sens prédéterminé (comme celel du phénomène du “pachinko”, 3 réponses “négatives” possibles, et 1 seule réponse “positive” possible, parmi 4 choix proposés aux sondés) :

Complotisme : l’Ifop utilise-t-elle le mentalisme pour influencer les sondages ?

C’est bien connu : pour les associations, observatoires et autres “instituts de lutte contre Ceci ou contre Cela”, rien ne vaut un bon vieux sondage alarmiste pour susciter des retombées médias et faire parler de soi. Ainsi, le commanditaire du sondage peut faire en sorte que les questions posées tendent à prouver tel ou tel phénomène alarmant. Histoire de prouver que le combat mené est juste, et qu’il faut par conséquent verser plus de crédits ou de subventions, ou multiplier les adhésions. […]

Beaucoup plus grave est le traitement de la question de l’immigration. […]

Fait remarquable, la thèse complotiste et négationniste selon laquelle le génocide juif n’a “jamais existé” obtient le score de … 0%. C’est une excellente nouvelle qui montre que les thèses négationnistes ne rencontrent aucun succès dans l’Hexagone, mais c’est précisément le fait que cet excellent score ne soit pas mis en avant par les commanditaires du sondage (ce score est absent du communiqué de la Fondation Jean Jaurès) qui est troublant -comme si seules les “mauvaises nouvelles” étaient importantes.

On signalera également cet excellent article de Reflets.info :

Théories du complot : mais quelle bande de cons !

Venons-en rapidement aux résultats du sondage dont les résultats font, comme le souligne Le Monde, « froid dans le dos », brrrrr. Nous, ils nous ont plutôt fait rire. Jaune. […]

Le sondage mélange tout et n’importe quoi, met tout sur le même plan : d’authentiques thèses complotistes, du créationnisme (« Dieu a créé l’homme et la Terre il y a moins de 10 000 ans »), du totalement absurde comme des propositions auxquelles il est plus facile d’adhérer — soit parce qu’elles sont plus plausibles, soit parce qu’elles ont fait l’objet de publicité, soit encore parce que les questions sont formulées de façon alambiquée. En clair, tout le truc sent le savonnage de planche, du début à la fin. […]

Entre autres choses, demander à quelqu’un son opinion, par définition, nécessite que cette personne soit capable de s’en forger une. Le sondage fait tout le contraire. […]

Le sondage ne propose que des questions fermées. On est d’accord ou pas d’accord avec les énoncés, aucune nuance n’est possible. Il ne propose même pas d’option de non-réponse. Le sondé doit être pour ou contre telle ou telle proposition. Pire, on demande aux personnes interrogées de se positionner sur des théories dont ils viennent de déclarer n’avoir pas connaissance. […]

Allez, cheese on the cake, le sondage nous apprend que la télévision, la radio et les journaux constitueraient le principal média d’information pour 70 % des sondés. Ceux-là même qui adhèrent paraît-il à des thèses complotistes. Assez cocasse quand on sait que c’est Internet qui est régulièrement pointé du doigt par les médias traditionnels, non ? […]

Dans le traitement médiatique de cette « étude », on peut aussi lire une confusion entre complotisme et fausses nouvelles sur fond de projets politiques croquignolesques. Les fake news sont avant tout des informations fausses fabriquées volontairement, forgées spécifiquement pour tenter d’influencer les individus. Rien à voir avec une théorie sur la Terre plate et autres débilités qui circulent sur le Web et emballent une poignée d’allumés adorateurs du Grand Nawak. […]

Le problème des fake news est un faux problème, basé sur la croyance que celles-ci influenceraient forcément les individus, les feraient changer d’avis, ce qui s’avère être assez contestable. Nous sommes donc face à des problèmes dont personne n’a vraiment démontré l’impact, avec un sondage contestable, dans une période d’emballement autour du sujet des fausses informations. Non, décidément, tout ça est très intéressant. […]

En attendant le prochain sondage, toute la rédaction tient à remercier la (trop) grande partie des médias français pour le traitement de cette « étude », qui n’a aucune valeur scientifique mais pourrait s’avérer une aubaine politique. C’est ce qu’on appelle du journalisme nuancé et réfléchi.

Notons aussi cette intéressante analyse issue d’un blog Médiapart : Lutter contre le complotisme, c’est lutter contre qui ?

Au vu de ces polémiques, Arrêts Sur Images a produit une intéressante émission sur ce sujet, consultable ici : Non, 80 % des Français ne sont pas complotistes !

Et nous terminerons par cette intéressante analyse d’un Youtubeur :

V. Conclusion

Laurent Callixte a parfaitement résumé le problème de ce sondage :

“Le malaise suscité par ce sondage vient du fait qu’il semble avoir été conçu pour donner un résultat alarmiste, suscitant des retombées médias et de nombreuses réactions sur les réseaux sociaux, et qu’il semble conçu pour légitimer l’action des commanditaires. Or il n’est pas sûr que l’on vienne à bout du complotisme en utilisant des méthodes de mentalisme et de manipulation mentale, puisque les complotistes reprochent justement aux élites et aux médias d’asservir la population grâce à des techniques de… manipulation.” (Source)

Ainsi, on peut noter que le commanditaire a pour habitude de mettre en avant des âneries propagées par une poignée de personnes non fiables (comme ici, où il cherche à interroger quelqu’un qui croit que la Terre est plate) :

Dès lors, comme ces personnes s’intéressent à “ce que pensent les fous”, eh bien, ils peuvent agiter le fantasme de réseaux sociaux qui “diffusent des folies”, ces commanditaires justifiant ainsi leur existence (quoiqu’on voit mal à quoi ils servent en pratique…).

Il est également à noter que ces “chiots de garde” ne cachent même pas leur objectif : empêcher les gens d’avoir ne serait-ce que de simples doutes sur les discours des gouvernements ou des médias (Source) :

Le plus grave est que les médias, avides de buzz, n’ont pas hésité à mettre les fausses informations de ce sondage hautement critiquable en avant, suscitant l’angoisse (Source) :

Le tout sans l’assumer (Source) :

Le danger de tout ceci est que cela ne peut que renforcer les tentatives des gouvernements de réglementer encore plus Internet, et donc de limiter la Liberté d’expression et d’information.

/image%2F0780719%2F20170521%2Fob_98bcb0_medias11.jpg)

/image%2F0780719%2F20191210%2Fob_a02dbd_douma-gaz1.jpg)

/image%2F0780719%2F20191001%2Fob_5866f2_fake-news1.jpg)

/image%2F0780719%2F20190919%2Fob_704f10_ilhan-omar1.jpg)

/image%2F0780719%2F20170828%2Fob_99abb3_nyt2.jpg)

/image%2F0780719%2F20240417%2Fob_5758b0_perenco1.jpg)

/file%2F0780719%2F20240417%2Fob_38ea50_hezbollah1.webp)

/file%2F0780719%2F20240417%2Fob_531a49_iran-arabie-saoudite2.webp)

/file%2F0780719%2F20240417%2Fob_8df2fd_kit-graph-1.webp)

/file%2F0780719%2F20240417%2Fob_8a3760_onu-salle.webp)

/image%2F0780719%2F20240417%2Fob_96ff05_cia.jpg)

Haut de page

Haut de page